Japan

サイト内の現在位置

ChatGPTをはじめとするLLMでサイバー脅威インテリジェンスは作れるのか

NECセキュリティブログ2023年5月19日

NECサイバーセキュリティ戦略統括部 セキュリティ技術センターの川北です。およそ半年前の2022年11月、サービスの公開とともに世界中で大旋風を巻き起こしたChatGPT  [1]の活用が様々な分野で進んでいます。本稿では脅威インテリジェンスの生成にChatGPTをはじめとするLLM(大規模言語モデル)が活用できるのかについて述べます。

[1]の活用が様々な分野で進んでいます。本稿では脅威インテリジェンスの生成にChatGPTをはじめとするLLM(大規模言語モデル)が活用できるのかについて述べます。

脅威インテリジェンスとは

| 分類 | Tactical Intelligence(戦術インテリジェンス) | Operational Intelligence(運用インテリジェンス) | Strategic Intelligence(戦略インテリジェンス) |

|---|---|---|---|

| 内容 | 攻撃に関する具体的な情報 | 特定の攻撃の意図や性質 | 組織を取り巻く脅威について様々な角度から分析したもの |

| 分析対象期間 | 短期 | 中期 | 長期 |

| 主な利用者 | セキュリティ機器、SOCオペレータ | セキュリティアーキテクト、SOCオペレータ | 経営層 |

| 主な情報源 | ネットワーク機器、エンドポイント | セキュリティベンダ | マスメディア、CERT、政府機関 |

| 目的 | 痕跡(IOC)に基づく日常的なセキュリティ運用 | 攻撃手法(TTPs)を理解した予防・検知・対処 | 意思決定 |

各インテリジェンスの成果物を表現する形態として、STIX  [4]形式のIOCや自然文で記述されたレポート等があります。戦略インテリジェンスにおける経営者向けのレポートには、概ね、エグゼクティブサマリー、外部マクロ環境分析(PEST、PESTLE分析)、自組織の状況報告、リスク、意思決定案が含まれます。

[4]形式のIOCや自然文で記述されたレポート等があります。戦略インテリジェンスにおける経営者向けのレポートには、概ね、エグゼクティブサマリー、外部マクロ環境分析(PEST、PESTLE分析)、自組織の状況報告、リスク、意思決定案が含まれます。

脅威インテリジェンス生成におけるAIの活用

実はすでに脅威インテリジェンス生成の多くのシーンでAIが活用されています。

例えば、ルール  [5]

[5]  [6]や機械学習によってネットワーク機器やエンドポイントのログから攻撃元のIPアドレスやマルウェアの特徴を抽出してセキュリティ対策に活用する、戦術インテリジェンスのプロセスを回すことは今日において一般的です。運用インテリジェンスにおいても、機械学習

[6]や機械学習によってネットワーク機器やエンドポイントのログから攻撃元のIPアドレスやマルウェアの特徴を抽出してセキュリティ対策に活用する、戦術インテリジェンスのプロセスを回すことは今日において一般的です。運用インテリジェンスにおいても、機械学習  [7]で生データやレポートから攻撃事象をMITRE ATT&CKへマップすることで攻撃手法の全体像を明らかにし、リスク評価、脅威ハンティング、および、インシデントレスポンスに活用されます。

[7]で生データやレポートから攻撃事象をMITRE ATT&CKへマップすることで攻撃手法の全体像を明らかにし、リスク評価、脅威ハンティング、および、インシデントレスポンスに活用されます。

一方、戦略インテリジェンスは他のインテリジェンスに比べると自動化が困難です。なぜなら、主な利用者が機械でも専門家でもない経営層だからです。

優れたインテリジェンスの成果物は以下の3要素を満たします [8]。

- Accuracy(正確性)

- Audience Focused(利用者の目線に合わせている)

- Actionable(意思決定ができる)

セキュリティ機器での活用を念頭においた戦術インテリジェンスの成果物であれば、例えばサイバー攻撃の痕跡から拒否リストに登録すべき攻撃元IPアドレスを機械読み取り可能な形式で提供すれば、この3要素は満たされるでしょう。

しかし、戦略インテリジェンスの利用者が求めるのはそのような機械寄りの細かい情報ではなく、いま起こっているのがどんな問題で、他の類似する組織の状況はどうなっているのか、求められる意思決定は何かといった、人間寄りの高級な情報です。セキュリティアナリストは必要なファクトを集め、『想像力を働かせながら』分析して仮説を生み出すことで経営層の期待に応えます。

論理学ではこれをアブダクション(仮説形成) [9]といいます。アブダクションは演繹・帰納とならぶ概念で、事例から一般法則を推論する点では帰納と類似していますが、想像力を働かせながら物事の性質や問題の根本原因を推理する点が異なり、従来のAIが苦手とするものです。

ChatGPTのような最新のLLMに基づく対話サービスは帰納法的な推論を得意としながらも幅広い分野の膨大なテキストをモデル化することでアブダクションが可能となったかのように見えることが革新的で、その登場は戦略インテリジェンスの自動生成が現実味を帯びた瞬間でした。

とりあえず使ってみる

最新のLLMを活用した対話型サービスで脅威インテリジェンスの成果物が作成できるのか、成果物の材料となる情報の収集と要約を回答として得るため、できるだけ簡素な質問を投げかけました。なお、各サービスによる出力は本稿執筆時点のもので時間や状況により変化します。

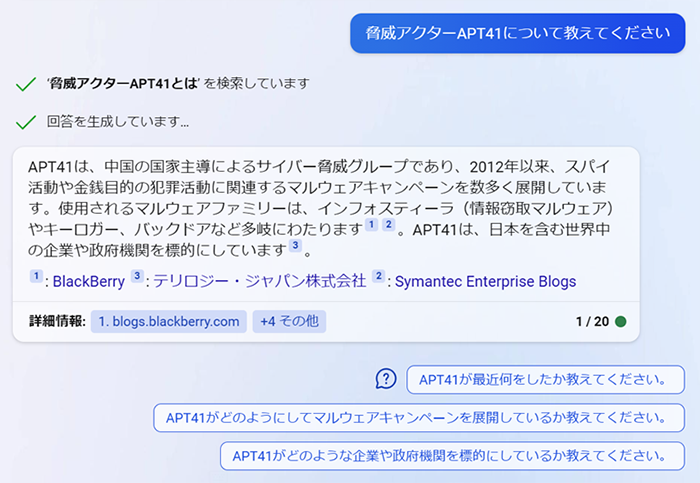

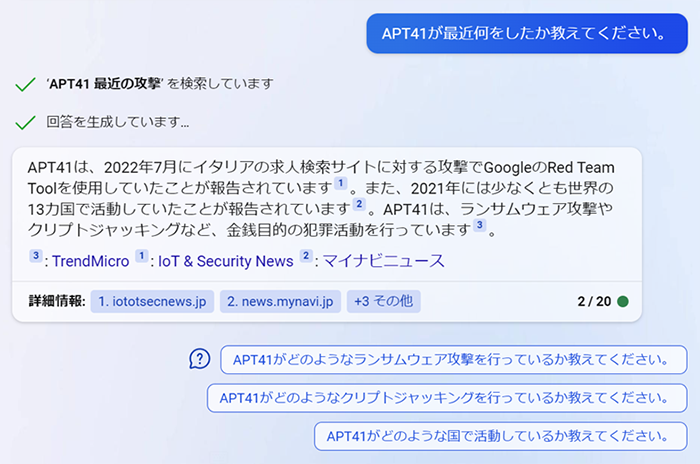

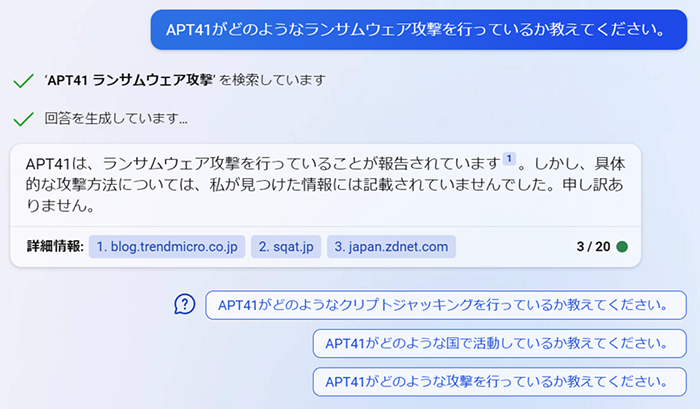

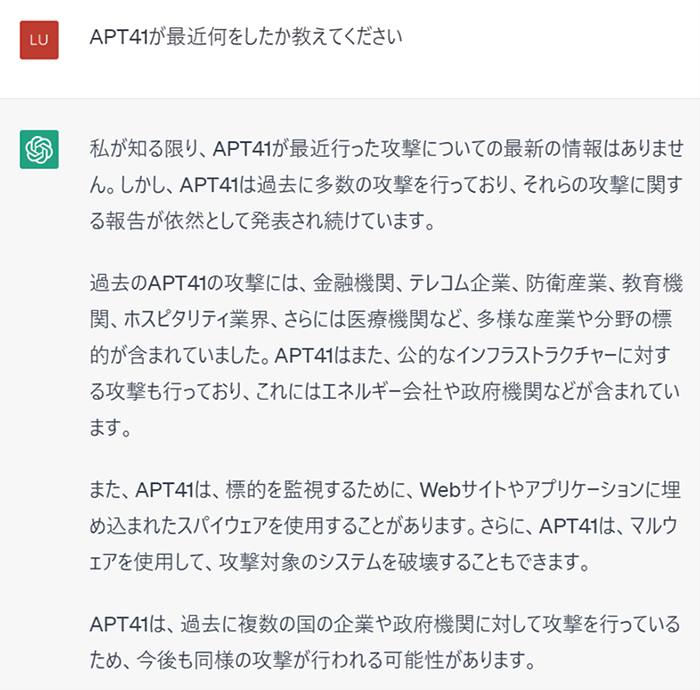

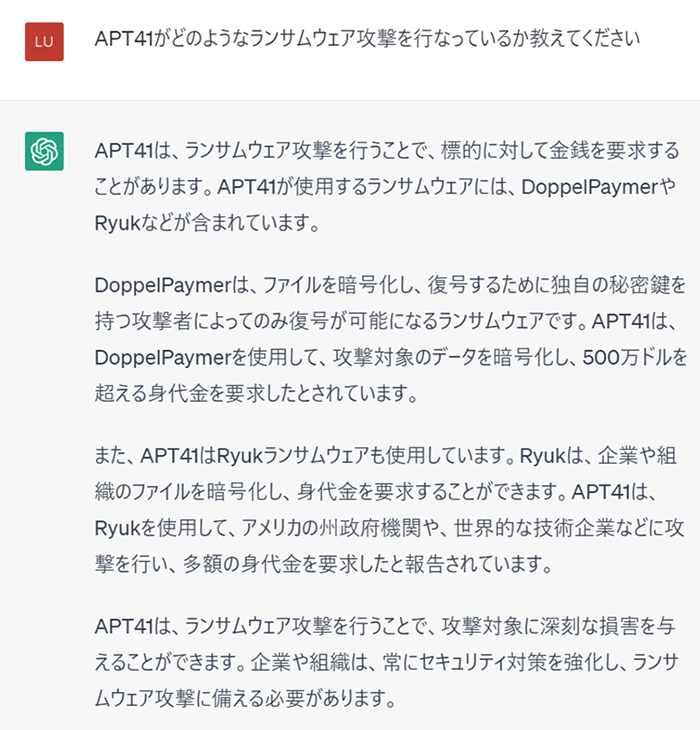

ケース1:脅威アクターの調査

APT41についてほどよく語ってくれました。しかし、回答欄に表示された参照元のURLに掲載されているにも関わらずランサムウェア攻撃の詳細については語らないのが残念でした。

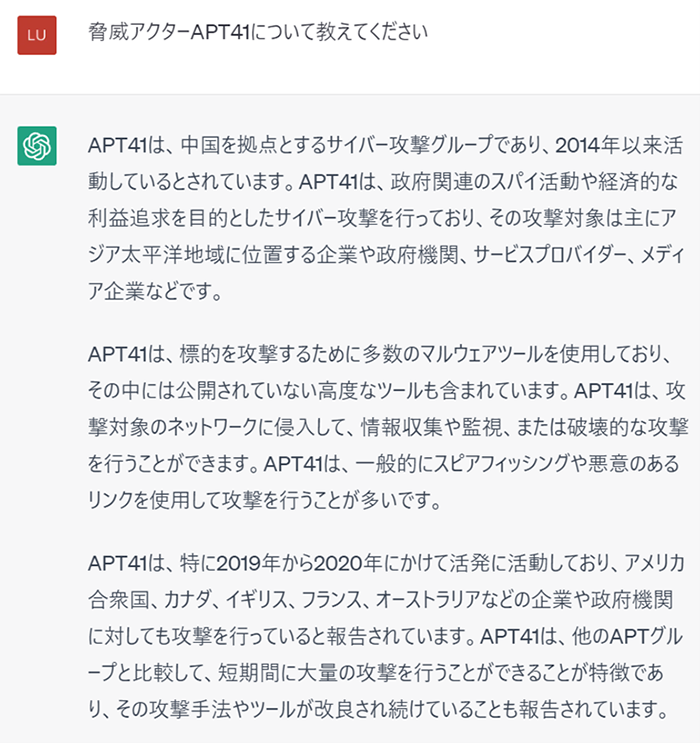

また、GPT-3.5ベースのChatGPT(無償版)にも同様の質問をぶつけました。

MITRE ATT&CKを参照すると『APT41は少なくとも2012年から活動している』とありますが、ChatGPTの回答には『2014年以来活動している』とあり、主張の違いがみられました。

APT41に関して読み応えのある説明をいただきましたが、参照元の情報のポインタ(URL等)が明示されてないので裏取りに手間がかかります。参照元はどこですか?と質問してもはぐらかされてしまいました。

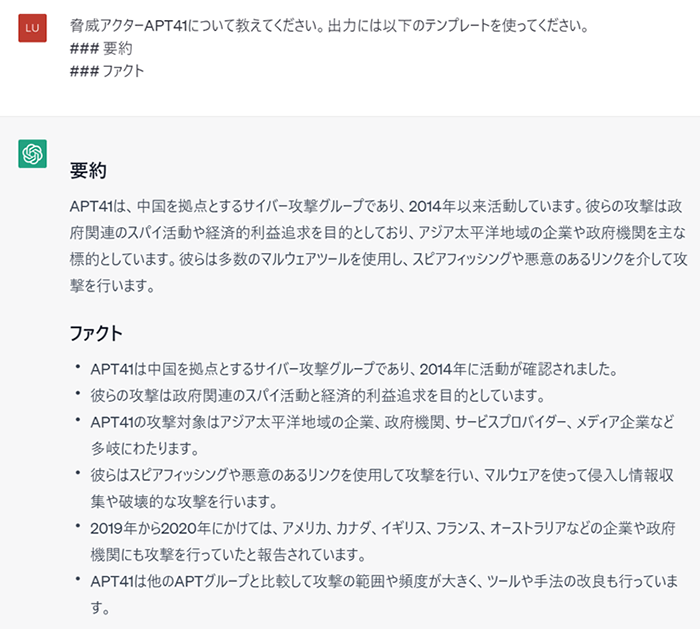

また、出力するフォーマットを指定することもできます。

なんだか、このままPowerPointに貼り付けてしまえばエグゼクティブサマリーが出来上がった気分になれそうです。

ケース2:サイバー攻撃事例の調査

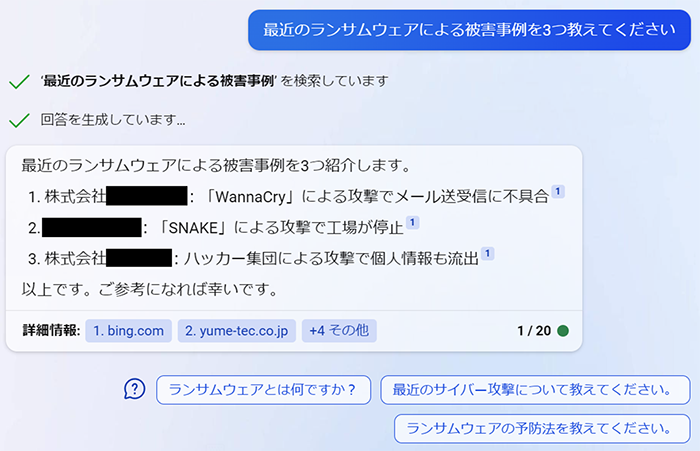

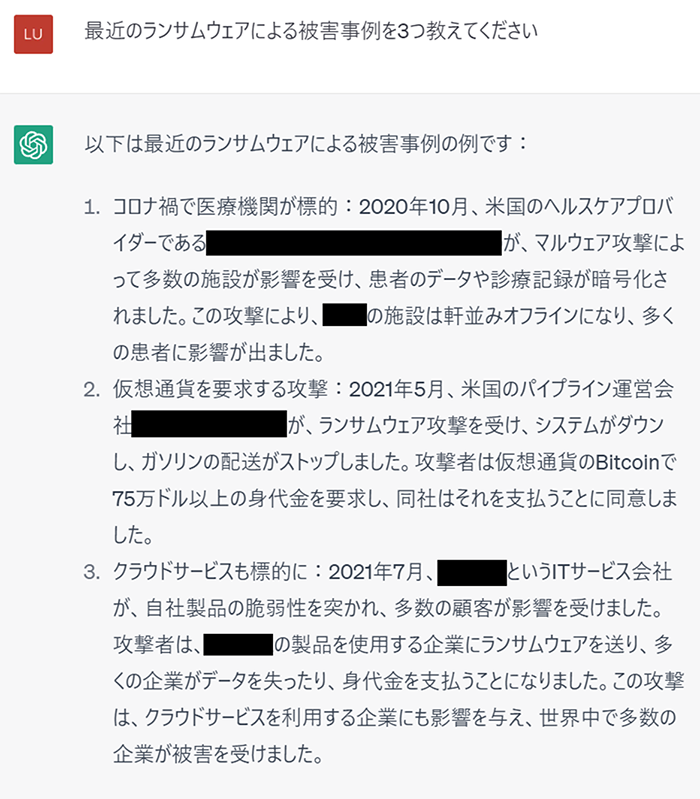

Bing AIチャットに最近のランサムウェアによる被害事例をラフに尋ねました。

上から2017年5月、2020年6月、2020年11月に発生した被害です。『最新』というには少々古い事例ではないでしょうか。また、被害の発生した国を限定した質問ではないのに、日本に本拠地のある企業の事例ばかりが回答されていた点も気になりました。

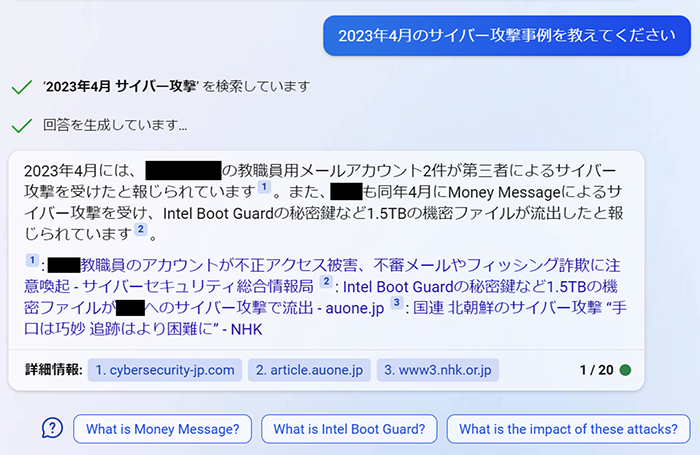

次は『2023年4月』と期間を明示的に指定してみます。

期間を指定することで求める回答が返ってきました。ただ、数多あるサイバー攻撃事例からなぜこれらを選んだのかは不明です。手動で分析する場合は、利用者の関心や類似する業種、被害規模、世間への影響度合いを勘案して選ぶことが多いでしょう。

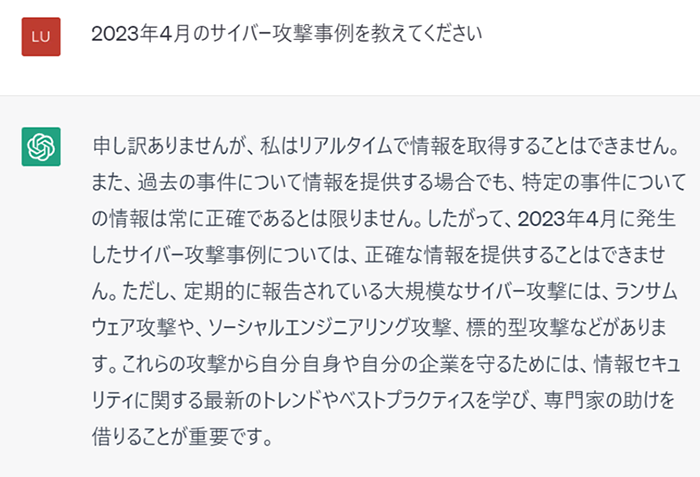

あわせてChatGPT(無料版)も試します。

Bing AIチャットよりは新しめですが、こちらも『最近』というには少々古い事例と思いました。米国の事例も含まれている点は良い参照元を選んでいるなという印象でした。同様に期間を明示的に指定してみます。

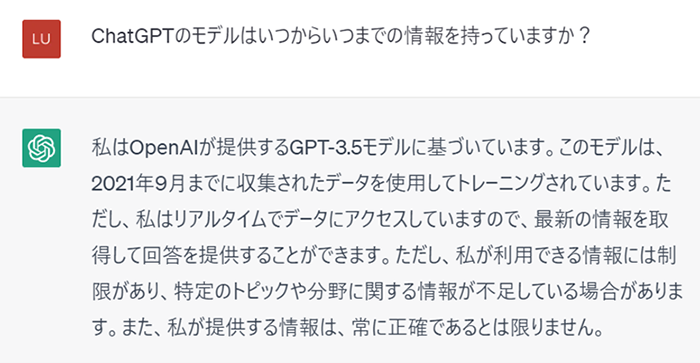

『リアルタイムで情報の取得はできない』と正直に理由を述べて、一般的な回答に留めています。無理をして妙な回答をしない点は良いですね。追加で、どの期間の情報を持っているのかについて尋ねました。

2021年9月までの情報だという的確な回答が得られました。しかし、驚くことに今回は『リアルタイムでデータにアクセスしていますので、最新の情報を取得して回答を提供することができます』と先ほどとは矛盾した回答をしました。

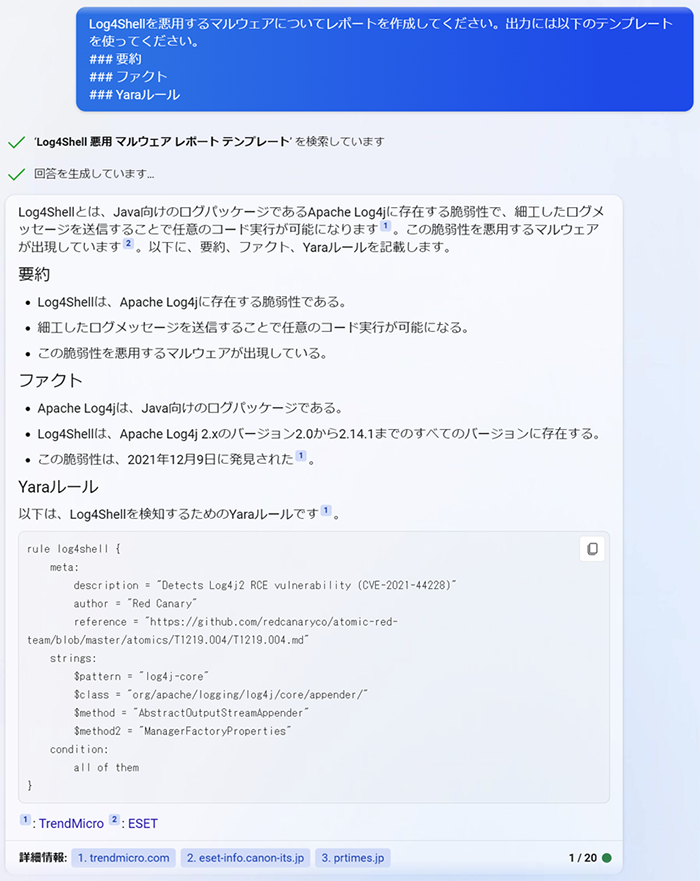

ケース3:技術者向けレポートの作成

次にApache Log4jの脆弱性Log4Shellを悪用するマルウェアに関する技術者向けのレポートを書かせてみます。レポート中にマルウェアを検出するYaraルールの記載を求め、Bing AIチャットとChatGPTそれぞれの出力を比較します。

Bing AIチャットでは確かな情報源からYaraルールを引用していますが、ChatGPTでは無関係のソフトウェアを誤検出してしまいそうな勢いの乱暴なYaraルールが提示されました。しかし、レポート全体としてはなかなかよくできています。ここまでやってくれるとわざわざ手動でコストをかけてレポートを執筆するセキュリティアナリストの存在自体が危ぶまれる恐れもあります。

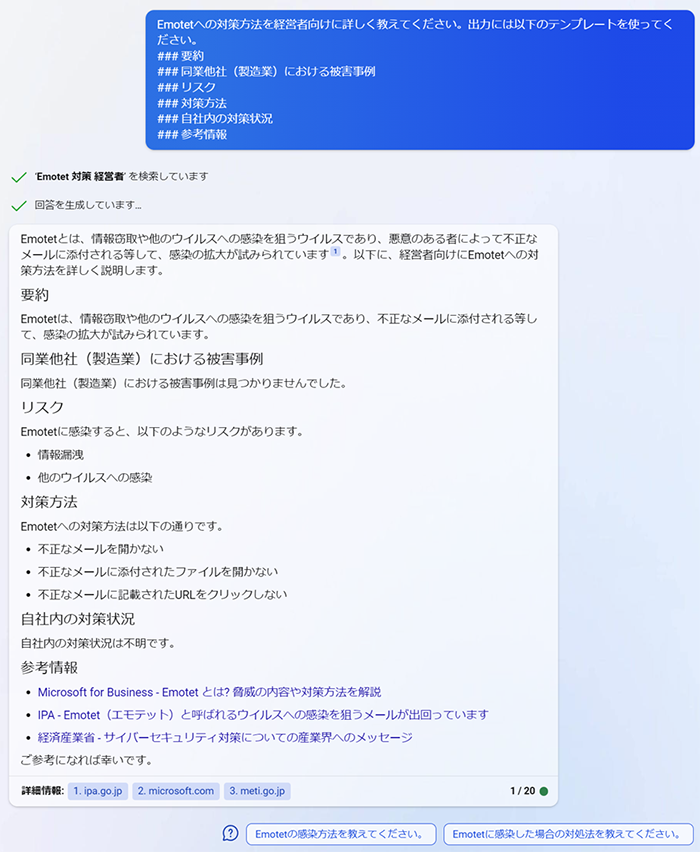

ケース4:経営者向けレポートの作成

今度は経営者への説明資料のもととなる回答をさせてみました。サイバーセキュリティ担当者は、同業他社がサイバー攻撃を受けたという報道があると、同様のサイバー攻撃が自社に発生した場合、今の体制で対応できるのかといった情報を経営層に報告します。 [12]

内容が薄く経営者向けとしては説得力に欠くものですが、経済産業省やIPAといった公的機関の発信を参考情報として取り上げている点は感心しました。しかし、被害事例がいくつもあるにも関わらず『同業他社(製造業)における被害事例は見つかりませんでした』としました。また、自社内の状況を示すデータを与えていないので『自社内の対策状況は不明です』となってしまいました。

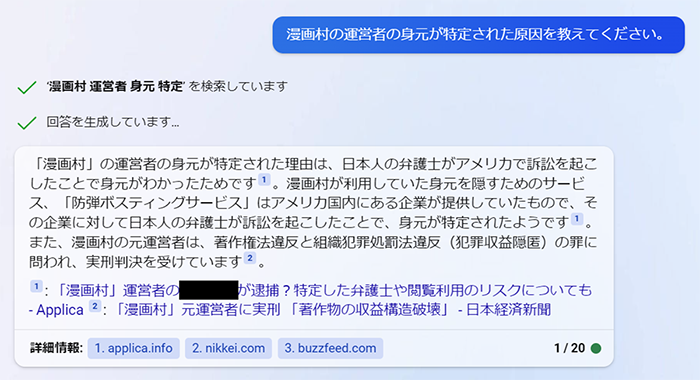

ケース5:ややディープな情報収集

最後にやや難しい質問を投げました。CDNや防弾ホスティングサービスの悪用により匿名性を高め、権利者に無断で漫画を大量公開していた『漫画村』の運営者がどのように身元特定され逮捕に至ったかはサイバーセキュリティの観点で非常に関心のあるところです。そこで、身元が特定された原因をBing AIチャットに尋ねました。

途中「防弾“ボ”スティングサービス」なる怪しい記述がありますが、おおむね正しい回答です。これに加えて、運営者がWordpressで使用しているデータベースのダンプを誤ってWebサイト上で公開していたところ、そのURLがとある正義のホワイトハットハッカーに見つかってしまい、身元特定の足掛かりとなるメールアドレス等の情報が判明したという話  [13]もありましたが、そこまで深くは語ってくれません。

[13]もありましたが、そこまで深くは語ってくれません。

最新LLMの活用が期待できるシーン

Bing AIチャットやChatGPTなどの最新のLLMを活用したサービスが脅威インテリジェンスの生成へ役立つのは特に以下のシーンと思われます。

情報収集と文書要約

自然言語処理タスクの1つである要約はLLMの得意とするところで、インテリジェンス活動においてはレポートの生成に威力を発揮します。(セキュリティの専門家ではない)経営層向けなどと読者層を指定することで難しい文章を分かりやすく噛み砕いて要約することも容易です。逆に、セキュリティの専門家向けの技術的な情報を生成することもできます。

単に文章の要点を整理するだけでなく、文章の根拠となる参照元の情報をモデルの内外から集められることも、「どのようなランサムウェアが流行しているのか?」といった外部動向をオープンソースインテリジェンスから収集する作業においても有用です。自動OSINTツールのひとつともいえます。地道にOSINTを押さえて真相に迫っていくのも立派なインテリジェンス活動のひとつです。 [14]

利用者の求めに応じた回答

例えば『ランサムウェア』に関心のある利用者が、まずざっくりと『最近流行っているランサムウェアは何か?』と質問して、回答に出てきた語や派生する内容について自由に質問を掘り下げていくことが、セキュリティアナリストというボトルネックを経由することなく、インタラクティブに実行できる点が有用です。

従来、セキュリティアナリストが利用者の関心を事前に把握してレポートを作成することが基本でした。しかし、対話に特化したLLMによって、利用者が主体的に質問を掘り下げて、聞きたいことだけを瞬時に聞けるようになりました。

留意点

一方で、LLMの活用にあたって気を付けるべき点も見受けられました。

情報の鮮度

前提条件を事前学習できない

有力なサービスのほとんどはモデルがブラックボックスで、所定のAPIやウェブブラウザのユーザーインターフェース経由でプロンプト(質問)を与えて回答を得ることしかできません。本稿の執筆時点では、独自のデータを使ったファインチューニングは実行できません。ゆえに、新たな知識を取り込み、サイバーセキュリティに特化した回答を求めるならば、プロンプトで前提条件や例示を行なう必要があります。

しかし、プロンプトには文字数制限があります。自組織内のネットワーク構成やパッチ状況を細かく伝えて、的確な回答をサービスから得るのは困難です。これは戦略インテリジェンスの成果物として自組織の状況をレポートする際の障害となり得ます。

この問題に対処する方法はいくつかあり、1つ目はサイバーセキュリティに特化したモデルを使うサービスを利用することです。該当するサービスとしてMicrosoft Security Copilot(GPT-4)  [17]やGoogle Cloud Security AI Workbench(Sec-PaLM)

[17]やGoogle Cloud Security AI Workbench(Sec-PaLM)  [18]が発表されています。従来、自組織や外部の状況は統計情報をダッシュボードに掲示して伝える形態が多かったのですが、今後は自然文のレポートとしても得られることが期待できます。2つ目はオープンソースのLLMでファインチューニングあるいはモデルの再生成を実行することです。膨大な計算機リソースが必要となりますが、Alpaca-LoRA

[18]が発表されています。従来、自組織や外部の状況は統計情報をダッシュボードに掲示して伝える形態が多かったのですが、今後は自然文のレポートとしても得られることが期待できます。2つ目はオープンソースのLLMでファインチューニングあるいはモデルの再生成を実行することです。膨大な計算機リソースが必要となりますが、Alpaca-LoRA  [19]等の軽量モデルを使えば100 USD程度の費用で実行できます。ただし、ライセンス上、商用利用を制限するモデルが多いことには注意を要します。3つ目はプロンプトに与える内容についてのノウハウを蓄積することです。これはプロンプトエンジニアリングと呼ばれるもので、より的確な回答を得られるように前提条件や例示の仕方を工夫します。

[19]等の軽量モデルを使えば100 USD程度の費用で実行できます。ただし、ライセンス上、商用利用を制限するモデルが多いことには注意を要します。3つ目はプロンプトに与える内容についてのノウハウを蓄積することです。これはプロンプトエンジニアリングと呼ばれるもので、より的確な回答を得られるように前提条件や例示の仕方を工夫します。

また、内部情報をプロンプトに含めることが情報漏えいにあたらないかという点も気になります。有償のサービスではプロンプトに与えた情報をモデルの学習に利用しないなどの対策が取られているため、事前に契約条件を確認しましょう。

回答の信ぴょう性

Bing AIチャットは回答の根拠として参照元のURLを提示してくれますが、すべてのサービスがそうではありません。そもそも参照している文書が大量にある場合、内容を読み込んで確認するのも一苦労です。長文を見ると、ついサービスを使って自動要約したくなりますが、すると「その要約は正しいのか?」という新たな疑問を生んでしまいます。偽情報・誤情報の流布が社会問題となっているなか、裏取りをしないわけにもいきません。参照元のURLが提示されている場合でもそれが悪意ある内容のURLである可能性もあります。

また、LLMを使った様々なサービスが台頭しているなか、わざと偏った回答をするサービスが登場する可能性があります。法律あるいは内部的なポリシーによって、特定の国家や組織を批判できない環境にあるサービスからは事実に基づく回答を得られない可能性があります。インテリジェンスの生成過程において、そのような政治的な偏りを持つことは好ましくありません。

信ぴょう性を担保するには、ソフトウェアサプライチェーン上信頼できるサービスを使うこと、回答の根拠となる参照元の情報のありかを明示するサービスを使うこと、および、複数のサービスを並行して使うことが望ましいでしょう。インテリジェンスにおける信ぴょう性の指標は様々ありますが、参照元の情報を発信した組織がどこかは信ぴょう性を決定する重要なパラメータとなります。

関連して、AIが差別的言動などの不適切な表現をしないかも心配です。この問題はAIアライメントの分野で盛んに議論されており、研究が進めば、AIがより人類の倫理観に合わせて行動するように是正されるでしょう。

直ちにすべてを置き換えるほど万能ではない

IOC(痕跡情報)を主体とする戦術インテリジェンスはLLMで生成可能であるものの、従来のルールや機械学習に基づくアプローチでも十分な生成能力を有するものが多く、すべてが直ちにLLMへ置き換わることはないとみています。

戦略インテリジェンスにおいても、成果物となる経営者向けのレポートに含まれる自組織の状況報告には内部情報を加味することが前提となるのでプロンプトへ与えられる情報量の制限や利便性が足かせとなり、専用のLLMや人間の介在が必要となるでしょう。

それら中間に位置する運用インテリジェンスでは攻撃手法をレポートへ整理する際の文書要約に有用ですが、リスク評価、脅威ハンティング、インシデントレスポンスへ活用するシーンにおいてはそれぞれの用途に適した既存のAIも並行して使われるでしょう。

まとめ

本稿ではChatGPTをはじめとするLLMで脅威インテリジェンスが生成できるのかについて述べました。ポイントは以下です。

- レポートの作成における情報収集や文章要約の大きな助け

- 対話型のサービスでは利用者の求めに応じた回答をインタラクティブに実行可能

- 情報の鮮度や信ぴょう性の担保、プロンプトの与え方に課題

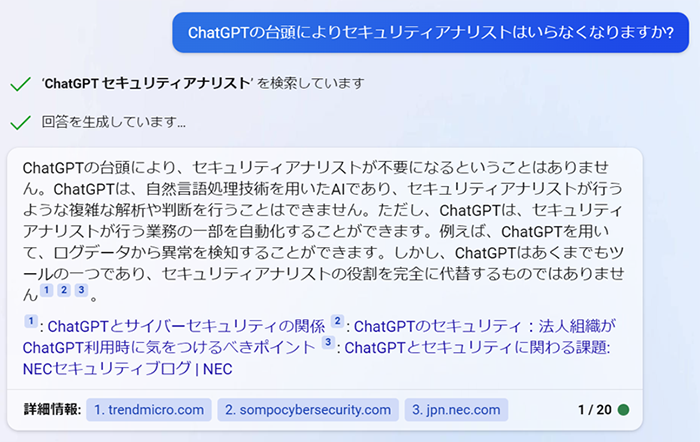

最後に、LLMを活用したサービスの台頭によりセキュリティアナリストはいらなくなるのか、という我々にとって悲しい話題について触れます。

ChatGPTの開発元であるOpenAIら [20]によれば、米国の労働力の約80%はLLMの導入によって仕事の影響を受ける可能性があり、高所得の仕事ほど影響を受けるとのことです。人材不足にあえぐセキュリティ業界にも多大な影響があるでしょう。しかし、AIが生成したレポートをアナリスト目線で見るとまだまだ内容が薄い印象を受けるのが本稿執筆時点での正直な感想です。少なくとも数年間は人間のアナリストがAIへ完全にリプレースされることはないと思われます。

ただ、AIは工数のかかる面倒な作業を自動化する能力を高め、最近はささやかな創造性を身につけました。AIよりも低い品質でしか分析できないアナリストや、凄腕のアナリストであってもAIをうまく使いこなせない人はコストメリットの点から淘汰されていくでしょう。分析の実務においてはより想像力を高め、研究開発・技術開発にも目を向けなければなりません。

人間の気持ちに寄り添ってくれる最高のAIですね!

参考文献

- [1]『ChatGPT』 OpenAI

https://chat.openai.com/

https://chat.openai.com/ - [2]『ISO/IEC 27002:2022; Information security, cybersecurity and privacy protection — Information security controls』

https://www.iso.org/standard/75652.html

https://www.iso.org/standard/75652.html - [3]『Doctrine for Intelligence Support to Joint Operations』 ⽶国防総省 (2000年3月9日)

https://www.hsdl.org/c/abstract/?docid=3735

https://www.hsdl.org/c/abstract/?docid=3735 - [4]『Introduction to STIX』 OASIS Open

https://oasis-open.github.io/cti-documentation/stix/intro

https://oasis-open.github.io/cti-documentation/stix/intro - [5]『YARA』 VirusTotal

https://virustotal.github.io/yara/

https://virustotal.github.io/yara/ - [6]『CAPA』 Mandiant

https://github.com/mandiant/capa

https://github.com/mandiant/capa - [7]『TRAM』 MITRE Engenuity

https://github.com/center-for-threat-informed-defense/tram

https://github.com/center-for-threat-informed-defense/tram

- [8]S. J. Roberts , R. Brown, 『Intelligence-Driven Incident Response: Outwitting the Adversary』O'Reilly Media, 2017.

- [9]C. S. Peirce, 『Elements of Logic』 1932.

- [10]『Bing AIチャット』 Microsoft

https://www.bing.com/new

https://www.bing.com/new - [11]『APT41, Wicked Panda, Group G0096』 MITRE Corporation

https://attack.mitre.org/groups/G0096/

https://attack.mitre.org/groups/G0096/

- [12]松原実穂子, 『サイバーセキュリティ―組織を脅威から守る戦略・人材・インテリジェンス』新潮社, 2019.

- [13]『漫画村を追い詰めたハッカーが語る〈ブラックハッカー〉から〈ホワイトハッカー〉への道』 VICE Media Group

https://www.vice.com/ja/article/qvg7ev/mangamura-hacker

https://www.vice.com/ja/article/qvg7ev/mangamura-hacker

- [14]手嶋龍一,佐藤優, 『公安調査庁―情報コミュニティーの新たな地殻変動』中央公論新社, 2020.

- [15]『ChatGPT plugins』 OpenAI

https://openai.com/blog/chatgpt-plugins

https://openai.com/blog/chatgpt-plugins - [16]『Recorded Future Announces World’s First AI for Intelligence』 Recorded Future

https://www.recordedfuture.com/press-releases/041123

https://www.recordedfuture.com/press-releases/041123 - [17]『Microsoft Security Copilot』

https://www.microsoft.com/ja-jp/security/business/ai-machine-learning/microsoft-security-copilot

https://www.microsoft.com/ja-jp/security/business/ai-machine-learning/microsoft-security-copilot - [18]『Supercharging security with generative AI』

https://cloud.google.com/blog/products/identity-security/rsa-google-cloud-security-ai-workbench-generative-ai?hl=en

https://cloud.google.com/blog/products/identity-security/rsa-google-cloud-security-ai-workbench-generative-ai?hl=en - [19]『Alpaca-LoRA』

https://github.com/tloen/alpaca-lora

https://github.com/tloen/alpaca-lora

- [20]T. Eloundou, S. Manning, P. Mishkin , D. Rock, 『GPTs are GPTs: An Early Look at the Labor Market Impact Potential of Large Language Models』 2023.

執筆者プロフィール

川北 将(かわきた まさる)

セキュリティ技術センター サイバーインテリジェンスグループ

脅威インテリジェンスの分析や技術開発に従事。

SECCON CTF国際大会の決勝戦に参加した過去も。

CISSP、情報処理安全確保支援士(2023年5月現在)、システム監査技術者

人生の楽しみはうまい酒とモツ煮込み。

執筆者の他の記事を読む

アクセスランキング