Japan

サイト内の現在位置

責任あるAI

注目が高まるホワイトボックス型AIとは

NECが目指す「信頼できるAI」とは

NECは予測結果の根拠を説明可能なAI=ホワイトボックス型AIをはじめとする、

プライバシーを含む人権の尊重や品質を考慮した「信頼できるAI」の提供を目指しています。

「信頼できるAI」がお客様の「責任あるAI」の活用を支えます。

注目が高まる「ホワイトボックス型AI」

なぜその判断・分類結果になったのか知りたい

AI活用が本格化・領域拡大する中で、壁にぶつかってしまうケースがあります。

その壁の一つが「AIがなぜその判断・分析結果を出したのか根拠が分からない」 というものです。

例えば、現在、広く利用され始めているディープラーニング。大量データから自動で特徴を見つけ出す特性を活かし、画像を使った製品検査業務などの効率化で成果をあげていますが、その結果に至った根拠を明らかにすることが難しく、「ブラックボックス」化されてしまいます。それが、一部の業務では課題になっているのです。

そこで、注目が集まっているのが、結果に至る理由(判断根拠)がわかる「説明可能なAI(Explainable AI,XAI)」=「ホワイトボックス型AI」です。

ブラックボックス型AIでの課題

改善点がわからず

精度の向上ができない

納得感や安心感がなく

意思決定につなげられない

説明責任が果たせない

ホワイトボックス型AIなら解決できる!

企業経営判断や人事採用、金融審査、医療など、人の意思決定が必要だったり、人がAIの判断結果から影響を受けたりするような場面では、AIには、なぜ、その結果を導いたのかがわかる「解釈性」が求められます。その解釈性を備えたのが「ホワイトボックス型AI」です。

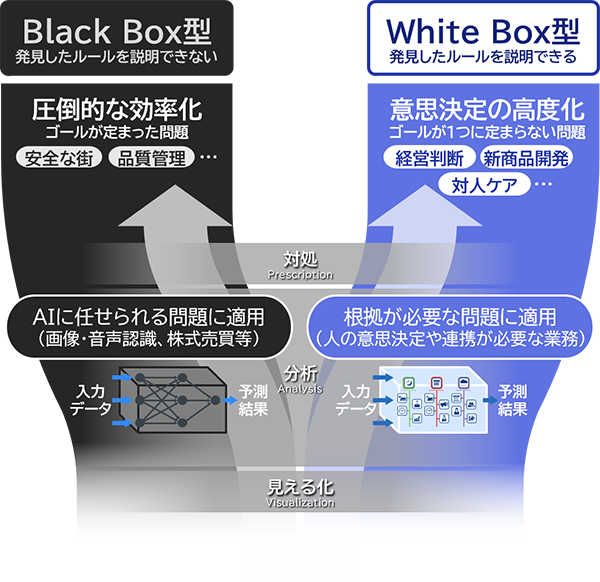

「効率化」と「高度化」、目的で選ぶAI

ブラックボックス型AIが得意なのは、前述の製品検査業務や真贋判定、劣化診断のようにAIに任せたい判断が明確で、パフォーマンスやスピードなど効率化を優先したい領域です。

一方、ホワイトボックス型AIが適した領域としては、ゴールが一つに定まらない問題で分析の理由の説明が必要なケースです。すでに活用が進む例では、小売・製造業における需要予測です。

消費者ニーズの多様化や商品ライフサイクルの短命化などによって、需要予測にはより高度な分析ノウハウが求められるようになっています。しかも、刻々と変化するマーケットに対応し、迅速に意思決定を行うには、その分析ノウハウの獲得に許された時間はごくわずかです。ホワイトボックス型AIなら、AIの予測結果と人の知見を組み合わせ、予測分析の精度を上げていくことが可能です。また、解釈性を備えているため、分析結果に対する納得感もあり、合意形成、意思決定をスムーズに行えます。

このようにAIが出した結果と理由を踏まえて人が考察し、意思決定や精度改善をしたり、新しい発見や示唆を得たりする──。「ホワイトボックス型AI」は、人と「協調」し、意思決定の高度化を行うことを得意としています。

誰もが最適な意思決定を行うために

さらにNECでは、最適な対処に導くために、「意図学習」技術を提供しています。

「意図学習」により、熟練者の経験によって培われた判断センスを学習・モデル化し再現することで、意思決定の品質を底上げし、最適な対処に繋げることができます。

社会実装が進むホワイトボックス型AI

ホワイトボックス型AIはすでに社会の様々なシーンで実装されています。

現場でも使いやすいAIと、使いこなしを支援する伴走型のサポートを得て、データサイエンティストではない人材が各々の業務課題を解決

需要予測の高度化を図ることで、市場ニーズへの機敏な対応と食品ロスの削減を両立

NASAの月探査計画「Artemis」向け有人宇宙船「Orion」の開発に採用

今、注目が集まるホワイトボックス型AIについて解説!

ホワイトボックス型AIを構成するNECのAI技術

なぜそのような予測や意思決定結果に至ったのか、根拠をわかりやすく提示することができるAI技術です。

効果がわかる事例集はこちら