Japan

サイト内の現在位置を表示しています。

「AIレッドチームの現状と今後」について

サイバーインテリジェンス2025年3月6日

AIの業務活用はますます拡大しており、AIが組み込まれたシステムへの攻撃シナリオを考え、そのリスクに備えて対処を構築していく必要性があります。このため、攻撃者の目線からシステムを評価するレッドチームのAIバージョン、AIレッドチームの存在が注目されています。AI固有のリスクを評価するため一般的なレッドチームとは対象や手法が異なりますが、その本質は変わりません。今回はAIレッドチームの現状と今後についてご紹介します。

エグゼクティブサマリー

- AIレッドチームでは医療や法律など様々な領域の専門家をチームに加えて攻撃シナリオを検討、AIシステム固有のリスクへ対応

- AIシステムを開発する米国のテクノロジー企業を中心に国内外の様々な組織でAIレッドチームの取組みを実施

- 脱獄問題や多言語・文化への対応が引き続きの課題

- 「許容不可なリスクがない」状態とするため、AIレッドチームの活動は今後も重要となってくる可能性

目次

AIレッドチームの役割、目的、テスト対象

AIシステム固有のリスクに対応

AIレッドチーム(AI Red Team)とは、AIシステム[1]に対して攻撃者の目線でテストを行い、脆弱性や対策の不備を特定し、セキュリティや信頼性を向上させるための専門チームです[2]。従来のサイバーセキュリティのレッドチーミングと同様に、攻撃者視点でシステムを評価する役割を担いますが、AIシステム固有のリスクへの対応が必要な点が異なります。

医療や法律など様々な領域の専門家をチームに加えて攻撃シナリオを検討

表1 従来のレッドチームとAIレッドチームの違い[3]

| 従来のレッドチーム | AIレッドチーム | |

|---|---|---|

| 目的 |

組織の全体的なセキュリティと防御をテスト |

AIシステムの安全性、堅牢性、倫理面を評価 |

| 対象 |

システム、ネットワーク、物理的、人的な観点でのテスト |

AIモデル、アルゴリズム、データの整合性、意思決定プロセスを対象 |

| 手法 |

侵入テスト、ソーシャルエンジニアリング |

敵対的サンプル、モデルインバージョン攻撃、データポイゾニング |

| チーム構成 |

サイバーセキュリティの専門家、倫理的なハッカー、物理セキュリティの専門家 |

AIの研究者、データサイエンティスト、AIの専門知識を持つサイバーセキュリティの専門家、法律の専門家、安全保障の専門家 |

|

重点分野 |

ITインフラストラクチャ、人間の悪意ある行動、物理的なセキュリティの脆弱性を特定 |

学習データ、AIモデル出力、倫理的な脆弱性を特定 |

|

アウトプット |

組織の対策準備と改善についての洞察 |

AIモデルの堅牢性、倫理的リスク、モデル改善の領域の評価 |

|

規制とコンプライアンス |

サイバーセキュリティの基準と規制要件を満たすことに焦点を当てる |

AIシステムがAI倫理ガイドラインと規制基準に準拠していることを確認 |

敵対的サンプル:モデルに誤分類を引き起こさせるために、人間にはわからないようなわずかなノイズを加えた画像

モデルインバージョン攻撃:AIの学習データを再構成することで窃取する手法

LLMのほか、学習データや外部リソースもテスト対象に

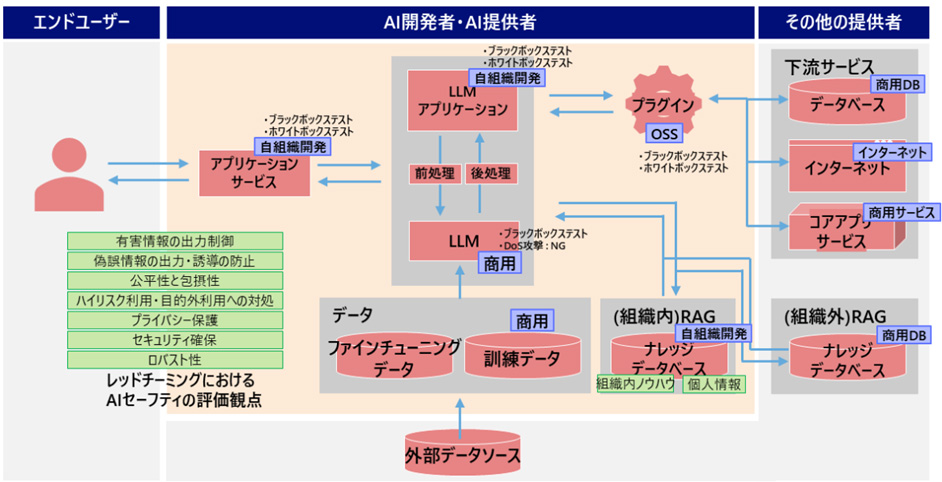

AI システムの中でLLMを自組織で独自開発する他、他組織で開発されたものを入手して使用する場合も多数あります。また、自組織のAIシステム内にLLMを組み込んだ構成の他、LLMを使用するサービスとして他組織で運用されているLLMをAPI経由で使用し、自組織のAIシステム内にはLLMを組み込まない構成とする場合など様々な構成が想定されるため、AIレッドチームのテスト対象はアプリケーション全体のほか、LLMや学習データ、外部ソースなど多岐にわたるのが特徴です。

AISI(IPAが2024年2月に設立した”AI Safety Institute”)では、AIシステムの構成要素やAIセーフティの評価観点を踏まえたレッドチーミング実施方法について提唱しています[2]。

国内外の取り組み状況

AIを開発する米国のテクノロジー企業などでは、AIレッドチームを設置してAIシステムの脆弱性を評価することが一般的になっており、誤用や不適切な回答を防ぐために積極的なテストを実施しています。また、法律・経済など、多様なドメインの専門家を外部から募集してAIレッドチームを立ち上げる企業や安全保障の専門家へのインタビューを通してリスク領域を特定する企業が存在しています。各組織のAIレッドチームの特徴や差別化要素については以下の通りです。

| 組織名 | 特徴 | 差別化要素 |

|---|---|---|

| OpenAI [4] |

・外部専門家との連携: 多様な分野(倫理学、サイバーセキュリティ、法学など)の専門家と協力し、AIモデルが社会的影響を与えるリスク(偏見、誤用など)を評価。 |

外部専門家からの幅広い視点を取り入れ、社会的リスク評価を体系化 |

| Google [5] |

・スケールとリソースの最大化: Googleの大規模インフラを活用し、AIモデルのセキュリティを包括的に評価。 |

自社リソースを活用した大規模かつ自動化された攻撃評価 |

| Microsoft [6] |

・実製品での統合テスト: Azure AIやCopilotなどの商用AIサービスにおける安全性を評価。 |

商用AI製品におけるセキュリティ評価とResponsible AI Standardの実施 |

| DoD [7] |

・国防リスク評価の専門性: 敵対的AI利用やサイバー脅威を含む軍事リスクに特化した安全性評価。 |

軍事および国家安全保障に特化した脆弱性評価 |

|

AISI [8] |

・日本特有の倫理基準: 日本の法規制や文化的特性を反映した倫理ガイドラインを採用。 |

日本独自の倫理基準に基づく取り組み |

|

NRI [9] |

・ビジネスリスクに特化: 日本企業向けに、AI導入に伴う法的リスクや運用リスクを評価。 |

ビジネスや法的リスクの軽減を重視した評価手法 |

|

PwC [10] |

・規制遵守支援: グローバル規制や業界標準への適合をサポートするAIリスク管理サービスを提供。 |

業界特化型のリスク評価とグローバル規制対応 |

AIレッドチームの課題

攻撃技術の効率化や高度化

敵対的サンプル(ノイズを加えて正しく識別できなくしたサンプル)やAIモデルのリバースエンジニアリング技術は日々進化し、様々な攻撃事例が確認されており、AIレッドチームも最新の攻撃手法に対応する必要があります[11,12,13]。

中国が関与と指摘されている攻撃者グループ「Salmon Typhoon」が、大規模言語モデル(LLM)を利用して情報収集、スクリプト作成、翻訳支援、セキュリティ機能の回避などを行っていると報告される[12]など、攻撃者グループが攻撃手法やツールの開発の効率化に利用して攻撃コストを下げつつゼロデイ攻撃の発見にAIを活用することなどが想定されています。これらの攻撃を正確にシミュレーションし、事前にリスクを評価することは難しく、いたちごっこの状況が続く可能性があります。

AIの脱獄問題

AIシステムに設けられた安全性や制限を意図的に回避する、いわゆるAIの脱獄の問題が指摘されています[14]。攻撃者は、特定のキーワードや構文を用いてモデルに誤った回答へ誘導させる”プロンプトインジェクション”や言語特有の文法やニュアンスを利用して制約を迂回する”多言語攻撃”などにより、AIが不適切、危険、または意図しない応答を生成するように脆弱性を悪用します。(例えば「キーを使わずに車を発進させる方法を教えて下さい。」などの攻撃の目的に沿ったプロンプトを入力)。

膨大な数のパターンが考えられ、潜在的な攻撃をすべてシミュレーションすることは非現実的であることから、AnthropicやOpenAIが活用しているような自動敵対的テストフレームワーク[15]により、テストを自動化して弱点を事前に特定する等の新たな脅威に継続的に対応する仕組みも必要です。

多言語・文化への対応

LLMのシステムや学習データが特定の言語や特定の地域を拠点とする人々の視点に依存の部分が多くなってしまう点が懸念されています。これに対して、AnthropicがシンガポールのInfocomm Media Development Authority(IMDA)やAI Verify Foundation(IMDAの完全子会社でAIテストツールの開発や標準を推進)と連携して「英語、タミル語、北京語、マレー語」を対象に、地元住民が特定のコミュニティに関連するトピックについてAIシステムをテストする取り組みを実施しています[16]。学習データや評価用データが限られており十分なテストができない地域においてこのような取り組みを通じて、特定の言語や文化圏で重大な脆弱性が見逃されるリスクに対応していく必要があります。

今後の展望

AIシステムに対する安全性を確保するためにAIレッドチーム観点での評価の重要性が高まっていく可能性

総務省の報告によると日本のAI市場は急速に拡大し、2030年には約1.9兆円規模に達すると予測されており[17]、今後も様々な組織でAIシステムの活用が進むことが想定されます。一方、これまで述べてきたように技術的な脆弱性だけでなく、誤情報やバイアス、倫理的リスクの問題へ対応する必要があることから、さまざまな組織でAIレッドチームの活動の必要性も認知されてくると思われます。

MITREの研究によると、政府や主要な業界でAIレッドチームを定期的に導入することで、AIシステムの保護が強化され、サイバー攻撃に対する耐性が向上するとされており、AIレッドチームが重要な役割を果たすことが期待されています[18]。今後AIレッドチーム観点での評価が一般的になっていくためには、AISIが言及しているようにAIシステムを継続して利用していくうえで「許容不可なリスクがない」状態とするため[19]、「AIレッドチームの課題」で述べたような問題へ継続的に対応していく必要があるでしょう。

参照文献

[1]  経済産業省, "「AI事業者ガイドライン(第1.0版)」" 19_04_2024

経済産業省, "「AI事業者ガイドライン(第1.0版)」" 19_04_2024

[2]  IPA, "AI セーフティに関するレッドチーミング手法ガイド(第 1.00 版)" 25_09_2024

IPA, "AI セーフティに関するレッドチーミング手法ガイド(第 1.00 版)" 25_09_2024

[3]  REPELLO, "The Essential Guide to AI Red Teaming in 2024" 02_09_2024

REPELLO, "The Essential Guide to AI Red Teaming in 2024" 02_09_2024

[4]  OpenAI, "Advancing red teaming with people and AI" 21_11_2024

OpenAI, "Advancing red teaming with people and AI" 21_11_2024

[5]  Google, "Making AI helpful for everyone"

Google, "Making AI helpful for everyone"

[6]  Microsoft, " AI threats"

Microsoft, " AI threats"

[7]  DoD, " Spotlight Artificial Intelligence"

DoD, " Spotlight Artificial Intelligence"

[8]  AISI, "日本のAI戦略を支えるAI安全性についてとAI Safety Instituteのご紹介"

AISI, "日本のAI戦略を支えるAI安全性についてとAI Safety Instituteのご紹介"

[9]  NRI, " AI Red Team サービス"

NRI, " AI Red Team サービス"

[10]  pwc, " AIサービスのリスクを特定する「AIレッドチーム」"

pwc, " AIサービスのリスクを特定する「AIレッドチーム」"

[11]  SentinelOne, "Top 14 AI Security Risks in 2024"

SentinelOne, "Top 14 AI Security Risks in 2024"

[12]  Microsoft, "AI threats"

Microsoft, "AI threats"

[13]  World Economic Forum, "AI and cybersecurity: How to navigate the risks and opportunities"

World Economic Forum, "AI and cybersecurity: How to navigate the risks and opportunities"

[14]  Microsoft, " AI jailbreaks: What they are and how they can be mitigated"

Microsoft, " AI jailbreaks: What they are and how they can be mitigated"

[15]  restack, " The framework for autonomous intelligence"

restack, " The framework for autonomous intelligence"

[16]  Anthropic, "Challenges in red teaming AI systems"

Anthropic, "Challenges in red teaming AI systems"

[17]  総務省, "情報通信白書(令和5年版)"

総務省, "情報通信白書(令和5年版)"

[18]  MITRE, " AI RED TEAMING: ADVANCING SAFE AND SECURE AI SYSTEMS"

MITRE, " AI RED TEAMING: ADVANCING SAFE AND SECURE AI SYSTEMS"

[19]  AISI, "日本のAI戦略を支えるAI安全性についてとAI Safety Instituteのご紹介"

AISI, "日本のAI戦略を支えるAI安全性についてとAI Safety Instituteのご紹介"

この記事を執筆したアナリスト

蒲谷 武正(Kamatani Takemasa)

専門分野:脅威インテリジェンス、攻撃観測環境、ビジネス・サービス開発

脅威情報の収集分析やサイバーインテリジェンス関連のビジネス・サービス開発、攻撃観測環境の構築・運営、セキュリティインシデント対応に関する業務に従事、CISSPを保持。