Japan

サイト内の現在位置を表示しています。

AIエージェントの導入に伴い生じる可能性のある人権リスクと必要な対応

NECは、AIの利活用に伴う新たな課題への対応を強化するため、AIと人権に関するガバナンスの遂行責任者が、法制度や人権、プライバシー、倫理に関する専門的な知見を有する外部有識者(議員)に、NECグループにおける取り組みを諮問するデジタルトラスト諮問会議を開催しています。会議は2019年から毎年2回開催しており、議員との対話をとおして取り組みの高度化と改善を図っています。今回は2025年3月に開催した会議の内容を紹介します。会議では、AIエージェントの導入に伴い生じる可能性のある人権リスクと必要な対応について諮問しました。

NECのAIエージェントの取り組み

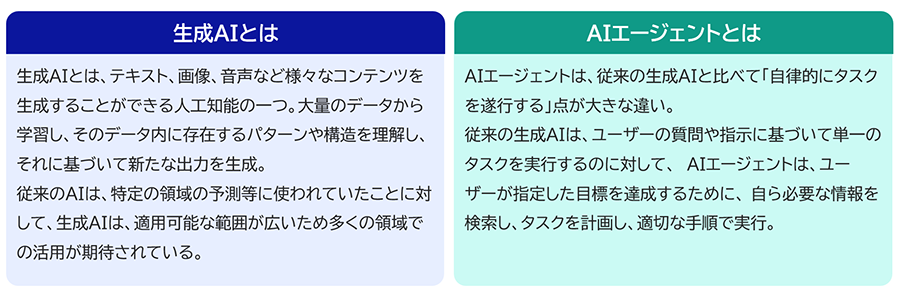

様々な企業や公共機関で、生成AIを活用した業務の効率化や自動化など、業務変革に向けた取り組みが始まっています。しかし、実際の業務で生成AIを活用する場合、意図に沿った適切なプロンプトを作成したり、複数のAIを組み合わせたりしないと回答精度を上げられないといった課題が顕在化してきました。そのため、業務ごとに最適なAIを構築するアプローチが一般的ですが、それには高度な専門知識、時間、コストが必要となります。

このような状況を背景に、NECは様々なAIやITサービスなどを連携させ、業務を自律的に遂行するAIエージェントの開発に注力し、推進してきました。

NECは、高度な専門業務の自動化による生産性向上の実現を目指し、生成AIをはじめとする様々なAIやITサービスなどを連携させ、業務を自律的に遂行するAIエージェントを、2025年1月から順次提供しています。 NECのAIエージェントは、ユーザーが依頼したい業務を入力すると、AIが自律的にタスク分解し必要な業務プロセスを設計します。さらに、それぞれのタスクに最も適したAIやITサービスなどを選択し、業務を自動で実行します。

AIエージェントを活用することで、高度な専門知識がないユーザーでも依頼したい業務を入力するだけで成果が得られるため、経営計画や人材管理、マーケティング戦略など、企業経営や業務運営に関わる高度な専門業務において、大幅な効率化が期待できます。

【関連リンク】

諮問事項:AIエージェントの導入に伴い生じる可能性のある人権リスクと必要な対応

今回の会議では、今後、当社が業務や機能に特化するなど、AIエージェントのサービス拡充を進め、さらなる生産性向上、業務効率化を支援するとともに、お客さまの業務変革の実現に貢献していくにあたり、AIエージェントの導入に伴い生じる可能性のある人権リスクと必要な対応について諮問しました。

議員のみなさまからは、主にAI全般のリスクや考慮すべき観点と、AIエージェントにより顕在化の可能性が高まるリスクや考慮すべき観点の双方で、以下ご意見をいただきました。

AI全般のリスクや考慮すべき観点

- 人間がもつ責任感、道徳性への影響

人間にはAIを過剰に信頼してしまう自動化バイアスがあるため、AIが出した結果や判断を深く考えずにそのまま受け入れて、人間の責任感や道徳性が弱まる可能性がある。AIが出した結果に対して、人間が実質的に判断をしないまま形式的に責任を引き受けるだけの存在になってしまう心配もある。このような状況を防ぐためには、人間とAIの関係性を適切に設計することが重要。 - 人間が関与することの必要性

AIの出力結果が、いつも適正で正確であるとは限らない。AIが学習に利用したデータに偏りがあると、偽情報や差別、偏見が含まれた結果を生成してしまうリスクがある。これらのリスクに対応するためには、AIの出力結果をそのまま鵜呑みにするのではなく、人間によるチェックが重要。B to Bのビジネスにおいては、お客さまにも協力していただき、共に確認する体制を整えることが望ましい。 - トレーサビリティの担保

もし人権侵害が発生した場合、原因を追跡し、適切な対応を取ることが非常に大切になるためトレーサビリティの担保が重要。一般論としてAIが扱うシステムは、複数の要素が並列して動作する場合が多く、どこかで失敗が発生する確率は高くなる傾向がある。そのため、ログを記録し、振り返り、検証する機会を設定することで、リスクの早期発見や適切な対応につなげることができる。

AIエージェントにより顕在化する可能性が高くなるリスクや考慮すべき観点

- 人間が意図しない出力結果

AIに与える目標が妥当だと考えられるものであったとしても、その目標を達成するためにAIが選択する手段が、意図せず人権侵害を起こしてしまう可能性があることに留意する必要がある。例えば、AIが過去のデータを基に統計的に最適な手段を選択した場合でも、その過去のデータ自体に偏見や差別が含まれていた場合、AIも偏った判断をしてしまうリスクがある。そのため、目標や手段の選択には、人権への影響を慎重に検討する必要がある。また、B to Bビジネスでは、直接的な取引相手だけでなくサービスや製品を利用するエンドユーザーの利益を考慮することが重要。仮に、AIの意思決定が、エンドユーザーの視点を無視する形で行われた場合、思いもよらない負の影響が生じることが考えられる。 - 責任の明確化

複数のAIエージェントが連携協力して作業を行う場合、問題が発生した時の責任の所在を明確化しておくことが重要。複数のAIが関わると、各AIがどのような役割を果たし、互いにどのように相互作用しているのかを把握するのが複雑になる。そのため、問題が発生した際に、それがどのAIによるものか、またはAI間の相互作用が原因なのかを特定することが困難になる可能性がある。そこで、事前にAIエージェントの役割や責任範囲を明確化しておくことで、問題発生時にも迅速な対処が可能となり、信頼性のあるAI利活用の推進につながるのではないか。 - 適用対象や範囲の限定

AIエージェントを活用する際は、上述したようなリスクや影響を考慮しながら適用範囲や対象を適切に限定することが重要。例えば、憲法学では、投票のような政治的な意思決定においては、人間の意思決定を最優先事項とすべきと考えられており、AIに任せてはいけない領域といえる。最初に人間が決めるべきことを明確化しておくことで、AIを効果的かつ倫理的に活用することができ、社会からの信頼を高めることにつながる。

NECでは今回いただいたご意見を参考に、AIエージェントに代表されるAIの新たな利活用によって生じ得るリスクへの対応を進め、人権尊重を最優先としたAIの利活用の促進に取り組んでいきます。