Japan

サイト内の現在位置を表示しています。

0から始める、AWS環境におけるHAクラスター構築手順解説~Linux編~

CLUSTERPRO オフィシャルブログ ~クラブロ~

はじめに

本ブログ(クラブロ)では、これまで多くのAmazon Web Services(以降、AWS)環境におけるHAクラスターの構築方法をご紹介してきました。

これらのHAクラスターを構築するためには、AWSの各種リソース、インスタンス、OS等を適切に設定する必要がありますが、紹介してきた記事では詳細な手順を省略している場合もありました。そのため、今回は入門用記事として詳細な手順を含めた解説をします。初めてCLUSTERPROによるAWS環境でのHAクラスター構築を行う方でもわかりやすいよう丁寧に解説しておりますので、ぜひ参考にしてください。

本記事は、AWS上でHAクラスターを構築する際に必要なAWSリソースの作成方法について紹介する「AWS設定編」と、EC2インスタンス上でのOSとCLUSTERPROの設定方法についてOS別に紹介する「Windows編」、「Linux編」に分かれており、今回は「Linux編」になります。AWSリソースの作成方法については「 AWS設定編」の記事を、Windows環境の設定方法については「

AWS設定編」の記事を、Windows環境の設定方法については「 Windows編」を参照してください。

Windows編」を参照してください。

この記事の内容

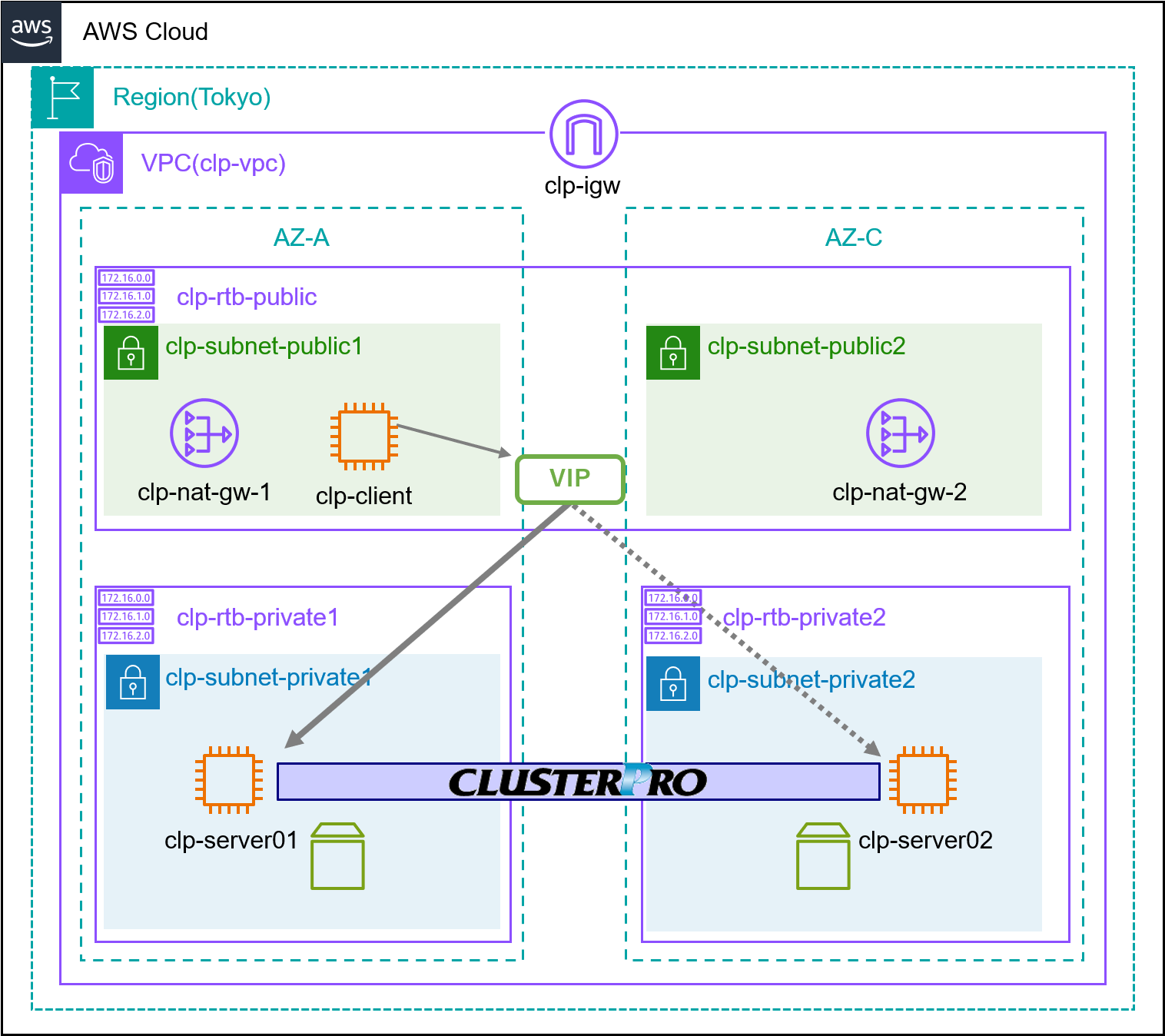

1. システム構成

AWS設定編で作成したEC2インスタンスを用いて、2ノードのミラーディスク型で、AWS仮想IPリソースを用いたVIP制御によるHAクラスターを構築します。

AWS設定編で作成したEC2インスタンスを用いて、2ノードのミラーディスク型で、AWS仮想IPリソースを用いたVIP制御によるHAクラスターを構築します。

EC2インスタンスの構成を以下に示します。本記事ではAWS設定編の記事とあわせて参照できるよう、IPアドレスやIDは構築した際の値をそのまま掲載しています。今後の設定においては各自の環境の値と置き換えて設定してください。

| 項目 | AZ-A上インスタンス | AZ-C上インスタンス |

|---|---|---|

| ホスト名 | clp-server01 | clp-server02 |

| OS | Red Hat Enterprise Linux 9.4 | |

| プライベートIPv4 | 10.0.110.196 | 10.0.120.224 |

| VPC ID | vpc-0dee5adc4ed51af6a | |

| インスタンスID | i-004217ccfbd6f06c6 | i-0fe2686d032545e09 |

| ENI ID | eni-05c85cbcabe615ba7 | eni-04549870b825dcd07 |

CLUSTERPROの構成は以下の通りです。

・ CLUSTERPRO

- フェールオーバーグループ(failover)

■ ミラーディスクリソース

- clp-server01

・ データパーティション

- マウントポイント:/mnt/mirror

- by-id:/dev/disk/by-id/nvme-

Amazon_Elastic_Block_Store_vol0e3bc0980e6ae993b-part2

・ クラスタパーティション

- by-id:/dev/disk/by-id/nvme-

Amazon_Elastic_Block_Store_vol0e3bc0980e6ae993b-part1

- clp-server02

・ データパーティション

- マウントポイント:/mnt/mirror

- by-id:/dev/disk/by-id/nvme-

Amazon_Elastic_Block_Store_vol0b17274675743e1be-part2

・ クラスタパーティション

- by-id:/dev/disk/by-id/nvme-

Amazon_Elastic_Block_Store_vol0b17274675743e1be-part1

■ AWS仮想IPリソース

・ IPアドレス:10.1.0.20

- NP解決リソース

■ タイプ:HTTP

・ ターゲット:aws.amazon.com

フェールオーバーグループには「ミラーディスクリソース」と「AWS仮想IPリソース」を追加しています。

ミラーディスクリソースはミラーディスクを制御するためのリソースです。ミラーディスク構成では、現用系と待機系のサーバーの間でデータをミラーリングし、フェールオーバー後も同一のデータにアクセスできるようにします。ミラーディスクの制御はパーティション単位で行われます。ミラーリングされる業務データが配置される「データパーティション」とCLUSTERPROがミラーリング制御のために利用する「クラスタパーティション」の2つを用意する必要があります。

AWS仮想IP(VIP)リソースは、AWS上のインスタンスにVIPアドレス経由でアクセスできるようにするためのリソースです。VIPアドレスを利用することで、クライアントはフェールオーバーが発生しても接続先を意識する必要がありません。VIPアドレスの切り替えは、CLUSTERPROがルートテーブルのルートを書き換えることで実現されます。

ネットワークパーティション(以降、NP)とは、クラスタサーバー間の全ての通信経路に障害が発生しネットワーク的に分断された状態を指します。この場合、複数のサーバーにおいてフェイルオーバーグループが起動する可能性があります。このような事態を避けるために、NP発生時に通信経路上のあるターゲットに対して通信確認を行い自身がネットワーク的に孤立したかどうかを確かめることができます。このような処理を行うリソースをNP解決リソースといいます。今回ターゲットにはAWSのWebサーバーを設定します。

2. Linux OSの設定

HAクラスター用インスタンス上のLinux OSで必要な設定を行います。

クライアント用インスタンスからclp-server01、clp-server02にSSH接続します。SSH接続にはEC2作成時に指定したキーペアをクライアント用インスタンス上に用意する必要があります。クライアント用インスタンスにはリモートデスクトッププロトコルで接続しているので、接続元(お手元の環境)でコピーしたファイルを接続先(クライアント用インスタンス)でペーストすることでファイル転送が簡単にできます。今回はデスクトップにキーペアを用意しました。

clp-server01にSSH接続します。クライアント用インスタンスからPowerShellまたはコマンドプロンプトを立ち上げ、cdコマンドでキーペアのディレクトリに移動します。clp-server01のIPアドレスを入力して接続します。

ssh -i clp-aws-key-pair.pem ec2-user@10.0.110.196

同様にclp-server02にもSSH接続を行い、以下の設定をそれぞれのインスタンス上で行います。掲載している例はclp-server01に対して実行したものです。

2.1 ホスト名変更

ホスト名を初期設定から変更します。変更後は再起動を行います。

$ sudo hostnamectl set-hostname clp-server01

$ sudo reboot

2.2 ミラーディスクの準備

インスタンスの作成時にアタッチしたEBSボリュームにミラー用パーティションを作成します。

CLUSTERPROでミラーディスクを利用するには、クラスタパーティションとデータパーティションの作成が必要です。

パーティションを作成するディスクのデバイスファイル名を確認します。AWS設定編で作成した5GBのEBSボリュームが「/dev/nvme1n1」として認識されていることが確認できました。

$ lsblk -p

NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINTS

/dev/nvme0n1 259:0 0 10G 0 disk

├─/dev/nvme0n1p1 259:4 0 1M 0 part

├─/dev/nvme0n1p2 259:5 0 200M 0 part /boot/efi

├─/dev/nvme0n1p3 259:6 0 1G 0 part /boot

└─/dev/nvme0n1p4 259:7 0 8.8G 0 part /

/dev/nvme1n1 259:1 0 5G 0 disk

fdiskコマンドでクラスタパーティションを作成します。ディスクサイズは1024MB以上を指定し、それ以外の項目は既定値とします。

$ sudo fdisk /dev/nvme1n1

Welcome to fdisk (util-linux 2.37.4).

Changes will remain in memory only, until you decide to write them.

Be careful before using the write command.

Device does not contain a recognized partition table.

Created a new DOS disklabel with disk identifier 0x7bc8c904.

Command (m for help): n

Partition type

p primary (0 primary, 0 extended, 4 free)

e extended (container for logical partitions)

Select (default p): p

Partition number (1-4, default 1): 1

First sector (2048-10485759, default 2048): 2048

Last sector, +/-sectors or +/-size{K,M,G,T,P} (2048-10485759, default 10485759): +1024M

Created a new partition 1 of type 'Linux' and of size 1 GiB.

続いてデータパーティションを作成します。今回はクラスタパーティションに割り当てた領域以外を全てデータパーティションに割り当てます。

Command (m for help): n

Partition type

p primary (1 primary, 0 extended, 3 free)

e extended (container for logical partitions)

Select (default p): p

Using default response p.

Partition number (2-4, default 2): 2

First sector (2099200-10485759, default 2099200):

Last sector, +/-sectors or +/-size{K,M,G,T,P} (2099200-10485759, default 10485759): 10485759

Created a new partition 2 of type 'Linux' and of size 4 GiB.

パーティションの設定をディスクに書き込みます。

Command (m for help): w

The partition table has been altered.

Calling ioctl() to re-read partition table.

Syncing disks.

EBSボリュームにパーティションが作成されたことを確認します。クラスタパーティションが「/dev/nvme1n1p1」、データパーティションが「/dev/nvme1n1p2」として作成されています。

$ lsblk -p

NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINTS

/dev/nvme0n1 259:0 0 10G 0 disk

├─/dev/nvme0n1p1 259:4 0 1M 0 part

├─/dev/nvme0n1p2 259:5 0 200M 0 part /boot/efi

├─/dev/nvme0n1p3 259:6 0 1G 0 part /boot

└─/dev/nvme0n1p4 259:7 0 8.8G 0 part /

/dev/nvme1n1 259:1 0 5G 0 disk

├─/dev/nvme1n1p1 259:2 0 1G 0 part

└─/dev/nvme1n1p2 259:3 0 4G 0 part

データパーティションに関して、ファイルシステムの作成を行います。今回はext4で作成します。

$ sudo mkfs -t ext4 /dev/nvme1n1p2

mke2fs 1.46.5 (30-Dec-2021)

Creating filesystem with 1048320 4k blocks and 262144 inodes

Filesystem UUID: 1a1b6a84-a42c-46a2-a013-1f7821618f85

Superblock backups stored on blocks:

32768, 98304, 163840, 229376, 294912, 819200, 884736

Allocating group tables: done

Writing inode tables: done

Creating journal (16384 blocks): done

Writing superblocks and filesystem accounting information: done

マウントポイントの作成を行います。

$ sudo mkdir /mnt/mirror

一般的なディスクの利用設定では、この後にOS側で自動マウントするための設定(/etc/fstabの設定等)を行いますが、CLUSTERPROのミラーディスクについてはCLUSTERPRO側でマウント制御を行うため、そのような設定は不要です。

最後にクラスタパーティションデバイス、データパーティションデバイスに対応するby-idを取得します。by-idとはハードウェアのシリアル番号に基づいて一意な名前が作成されるデバイスファイルのシンボリックリンクです。AWS環境では運用中にデバイスファイル名が変更される可能性があります。by-idを用いてデバイスファイル名を指定することで、運用中にデバイス名が入れ替わっても正しくデバイスを識別することができます。

以下のコマンドによりby-idと対応するデバイス名を確認できます。

「Amazon_Elastic_Block_Store_vol0e3bc0980e6ae993b-part1」がクラスタパーティション、「Amazon_Elastic_Block_Store_vol0e3bc0980e6ae993b-part2」がデータパーティションであることを特定できます。これらの情報はクラスター構成情報作成時に利用するので、by-idの先頭に「/dev/disk/by-id」をつけた絶対パスをそれぞれ控えておきます。

$ ls -l /dev/disk/by-id

lrwxrwxrwx. 1 root root 15 Jun 11 03:54 nvme-Amazon_Elastic_Block_Store_vol0e3bc0980e6ae993b-part1 -> ../../nvme1n1p1

lrwxrwxrwx. 1 root root 15 Jun 11 03:54 nvme-Amazon_Elastic_Block_Store_vol0e3bc0980e6ae993b-part2 -> ../../nvme1n1p2

★コマンド実行結果から抜粋しています★

以上でミラーディスクの準備は完了です。

2.3 AWS CLIのインストールと設定

AWSサービスをCLUSTERPROから制御するために、AWS CLIをインストールします。

インストールしたzipファイルを解凍するために、unzipをインストールしておきます。

$ sudo dnf -y install unzip

AWS CLIをダウンロードします。以下のコマンドを実行してzipファイルを取得します。

$ curl "https://awscli.amazonaws.com/awscli-exe-linux-x86_64.zip" -o "awscliv2.zip"

ダウンロードしたZIPファイルを解凍します。

$ unzip awscliv2.zip

解凍したディレクトリに移動し、以下のコマンドでインストールを実行します。

$ sudo ./aws/install

次のコマンドを実行してバージョン情報が表示されれば、正常にインストールができています。

$ aws --version

AWS CLIのインストール手順の詳細については、以下のリンクを参照してください。

インストールが完了したら、以下のコマンドを実行してAWS CLIの設定を行います。

$ sudo aws configure

AWS Access Key ID [None]: (Enterのみ)

AWS Secret Access Key [None]: (Enterのみ)

Default region name [None]: ap-northeast-1

Default output format [None]: text

今回はIAMロールを割り当てているので、アクセスキーに関する設定は不要です。そのため、AWS Access Key ID/AWS Secret Access Keyは値を未設定(Enter入力のみ)とし、Default region name/Default output formatに設定を割り当てます。今回は東京リージョン上にVPCを作成したのでDefault region nameはap-northeast-1を指定し、Default output formatはtext形式を指定しました。

3. CLUSTERPROの設定

CLUSTERPROのインストール、ライセンス登録、インストール後の設定を行います。

キーペア、CLUSTERPROのインストーラーとライセンスファイルをクライアント用インスタンスのデスクトップなど任意の場所に用意します。今回はCLUSTERPRO X 5.2の 試用版を利用しました。ミラーディスクを利用する場合は本体ライセンスとは別にReplicatorライセンスが必要です。

試用版を利用しました。ミラーディスクを利用する場合は本体ライセンスとは別にReplicatorライセンスが必要です。

まずCLUSTERPROのインストーラーを転送します。PowerShellまたはコマンドプロンプトを立ち上げ、キーペアとインストーラーを用意したフォルダにcdコマンドで移動します。scpコマンドを用いて転送する場合は以下のようなコマンドを実行します。

scp -i <キーペアのパス> <コピー元のファイル> ec2-user@<プライベートIPアドレス>:<コピー先のディレクトリ>

以下はインストーラーをclp-server01のユーザーディレクトリに転送する例です。

scp -i clp-aws-key-pair.pem x52l_x64.zip ec2-user@10.0.110.196:~

同様の手順でclp-server01、clp-server02それぞれにインストーラーとライセンスファイルを転送します。

クライアント用インスタンスからclp-server01、clp-server02にSSH接続し、lsコマンドなどでファイルが転送できていることを確認します。インストーラーはunzipコマンドで展開しておきます。

3.1 CLUSTERPROのインストール

CLUSTERPROのインストールを行います。今回使用したCLUSTERPRO X 5.2の試用版では、<zipファイルの展開ディレクトリ>/x52l_x64/Linux/5.2/jp/serverにrpmパッケージがあります。rpmパッケージのディレクトリまでcdコマンドで移動し、以下のコマンドを実行します。

$ sudo rpm -i clusterpro-5.2.1-1.x86_64.rpm

$ rpm -qi clusterpro

Name : clusterpro

Version : 5.2.1

Release : 1

Architecture: x86_64

Install Date: Tue 10 Jun 2025 04:35:23 AM UTC

Group : Applications/System

Size : 77060472

License : commercial

Signature : (none)

Source RPM : clusterpro-5.2.1-1.src.rpm

Build Date : Mon 17 Jun 2024 02:08:53 AM UTC

Build Host : uxg153034

Summary : CLUSTERPRO X for Linux (x86_64)

Description :

CLUSTERPRO X 5.2 for Linux(x86_64)

3.2 インストール後の設定

CLUSTERPROのインストール後に必要な設定を行います。clp-server01、clp-server02それぞれに対して以下の設定を行います。

3.2.1 ファイアウォールの設定

CLUSTERPROのインストールが完了したら、ファイアウォールのルールを追加します。今回使用しているRHEL 9.4のEC2インスタンスでは初期状態でファイアウォール(firewalld)が未導入であるため、OS上で通信の制御が不要である場合は本手順は不要です。以下ではファイアウォールを導入する場合の手順を説明します。

CLUSTERPROはモジュール間の通信にいくつかのポート番号を使用します。通信のためのルールを手動で設定することも可能ですが、clpfwctrl.shコマンドを用いることで簡単にルールを設定することができます。firewalldがインストールされていない場合、以下のコマンドでインストールします。

$ sudo dnf -y install firewalld

$ sudo systemctl start firewalld

以下のコマンドを実行します。

$ sudo clpfwctrl.sh --add

Command succeeded.

ルールが追加されたことを確認します。

$ sudo firewall-cmd --list-all

public (active)

target: default

icmp-block-inversion: no

interfaces: eth0

sources:

services: clusterpro cockpit dhcpv6-client ssh

ports:

protocols:

forward: yes

masquerade: no

forward-ports:

source-ports:

icmp-blocks:

rich rules:

3.2.2 SELinuxの設定

SELinuxの設定を行います。CLUSTERPROをインストールした直後にclpselctrl.shコマンドを実行します。実行前に必要なパッケージをインストールしておきます。

$ sudo dnf -y install policycoreutils-python-utils

以下のコマンドを実行します。

$ sudo clpselctrl.sh --add

clpselctrl.sh : Command succeeded.

$ sudo clpselctrl.sh --check

OK

-

CLUSTERPRO X 5.2 > Linux > インストール&設定ガイド

→ 第 2 章 システム構成を決定する

→ 2.8. ハードウェア構成後の設定

→ 2.8.7. ファイアウォールの設定を確認する (必須)

→ 2.8.10. SELinuxに関する設定をおこなう (必須) -

CLUSTERPRO X 5.2 > Linux > リファレンスガイド

→ 第 9 章 CLUSTERPRO コマンドリファレンス

→ 9.32. ファイアウォールの規則を追加する (clpfwctrl.sh コマンド)

→ 9.33. SELinux 用の設定をおこなう (clpselctrl.sh コマンド)

3.3 ライセンス登録

clplcnscコマンドを用いてライセンスファイルを指定してライセンスを登録します。本体ライセンス(BASE)とミラーディスク用のライセンス(REPL)を登録します。

$ sudo clplcnsc -i base5x_lin_trial_cpulcns.key

<Filename : /home/ec2-user/Lisence/base5x_lin_trial_cpulcns.key>

<Serial No : NECuser> License registration succeeded.

Processed license num (success: 1, error: 0).

$ sudo clplcnsc -i repl5x_lin_trial_nodelcns1.key

<Filename : /home/ec2-user/Lisence/repl5x_lin_trial_nodelcns1.key>

<Serial No : NECuser1> License registration succeeded.

Processed license num (success: 1, error: 0).

登録したライセンスを確認します。

$ sudo clplcnsc -l -a

ライセンス登録を行ったらインスタンスを再起動します。

$ sudo reboot

4. クラスター構成情報の作成

Cluster WebUIに接続し、クラスター構成情報の作成を行います。

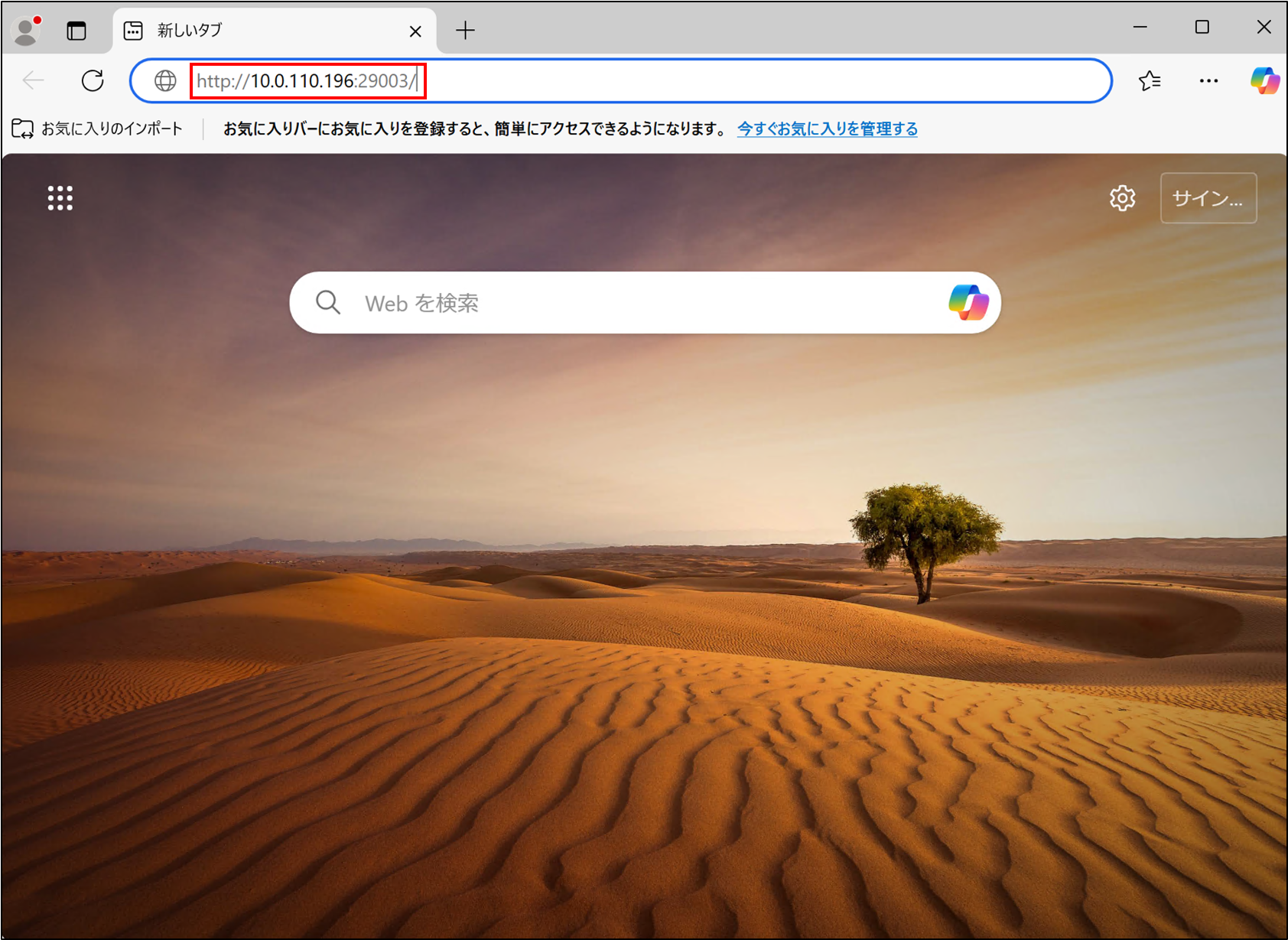

クライアント用インスタンスでWebブラウザを起動します。WebブラウザのアドレスバーにHAクラスターのマスタサーバーに設定するサーバーのIPアドレスとポート番号(既定値:29003)を入力します。

http://<EC2インスタンスのプライベートIPアドレス>:<ポート番号>/

clp-server01をマスタサーバーとする場合、以下のように入力します。

http://10.0.110.196:29003/

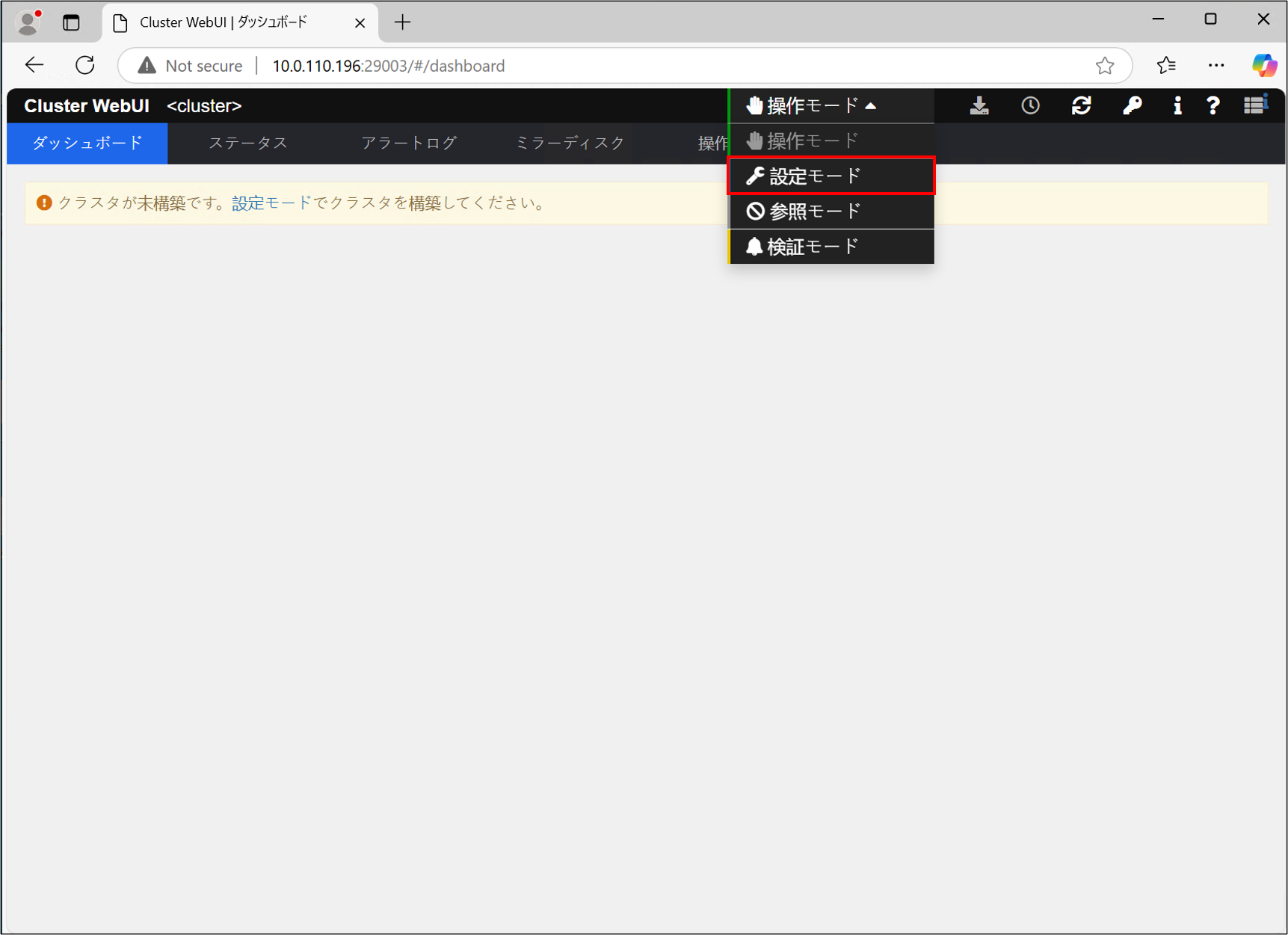

Cluster WebUIのダッシュボードが開きます。上部タブから設定モードを開きます。

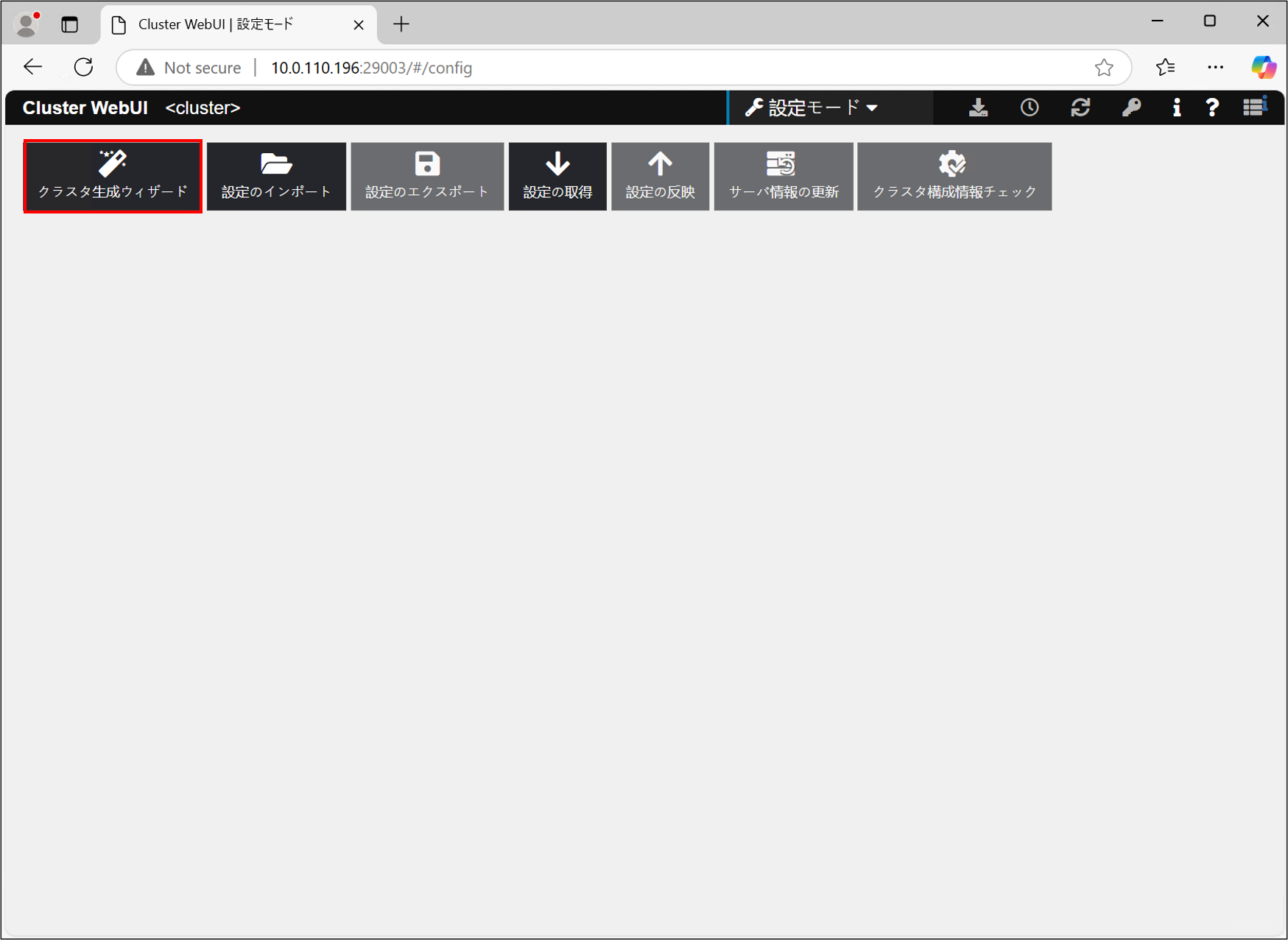

クラスタ生成ウィザードを開きます。

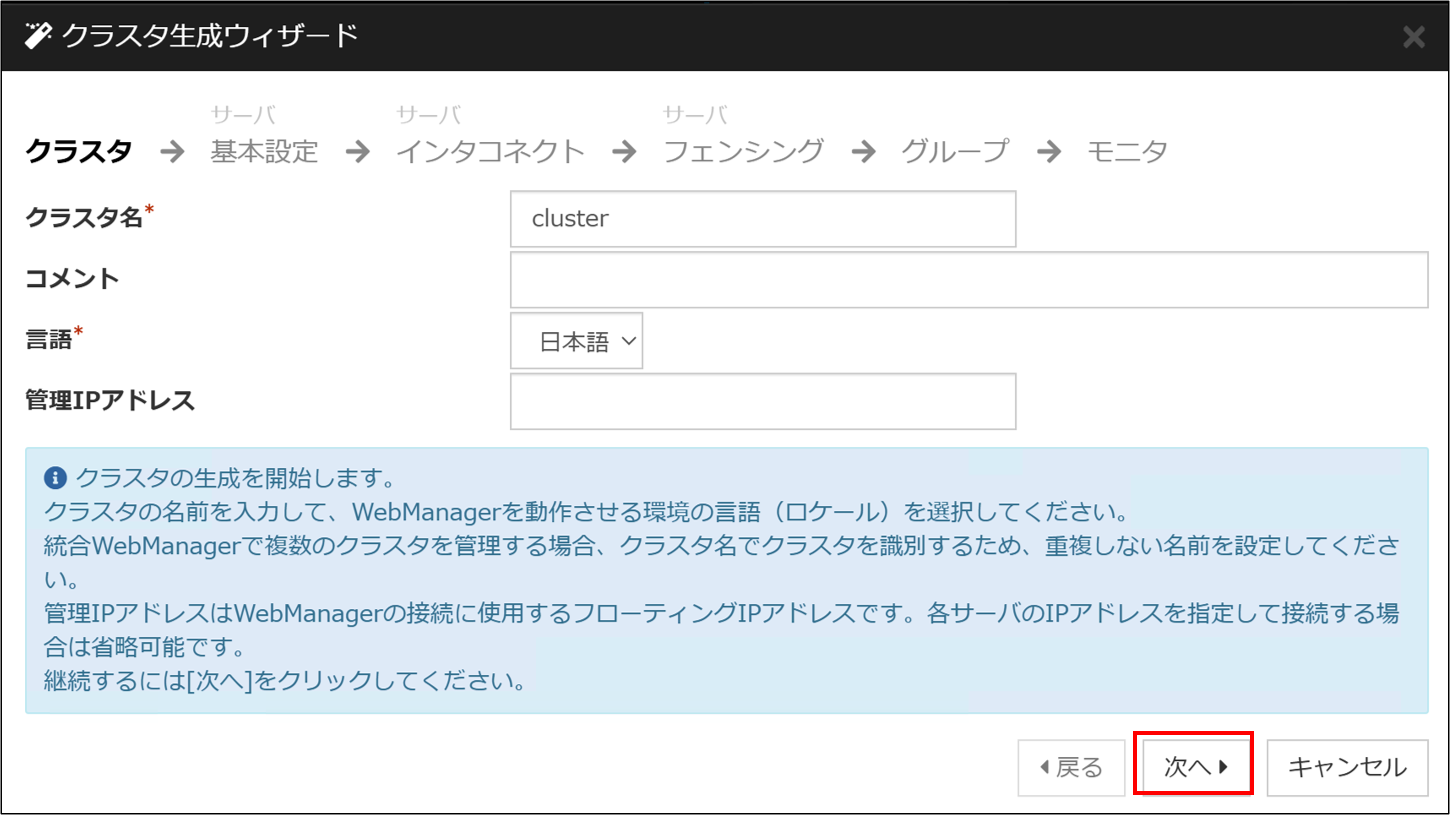

クラスタ名と言語は既定値のまま[次へ]を押します。

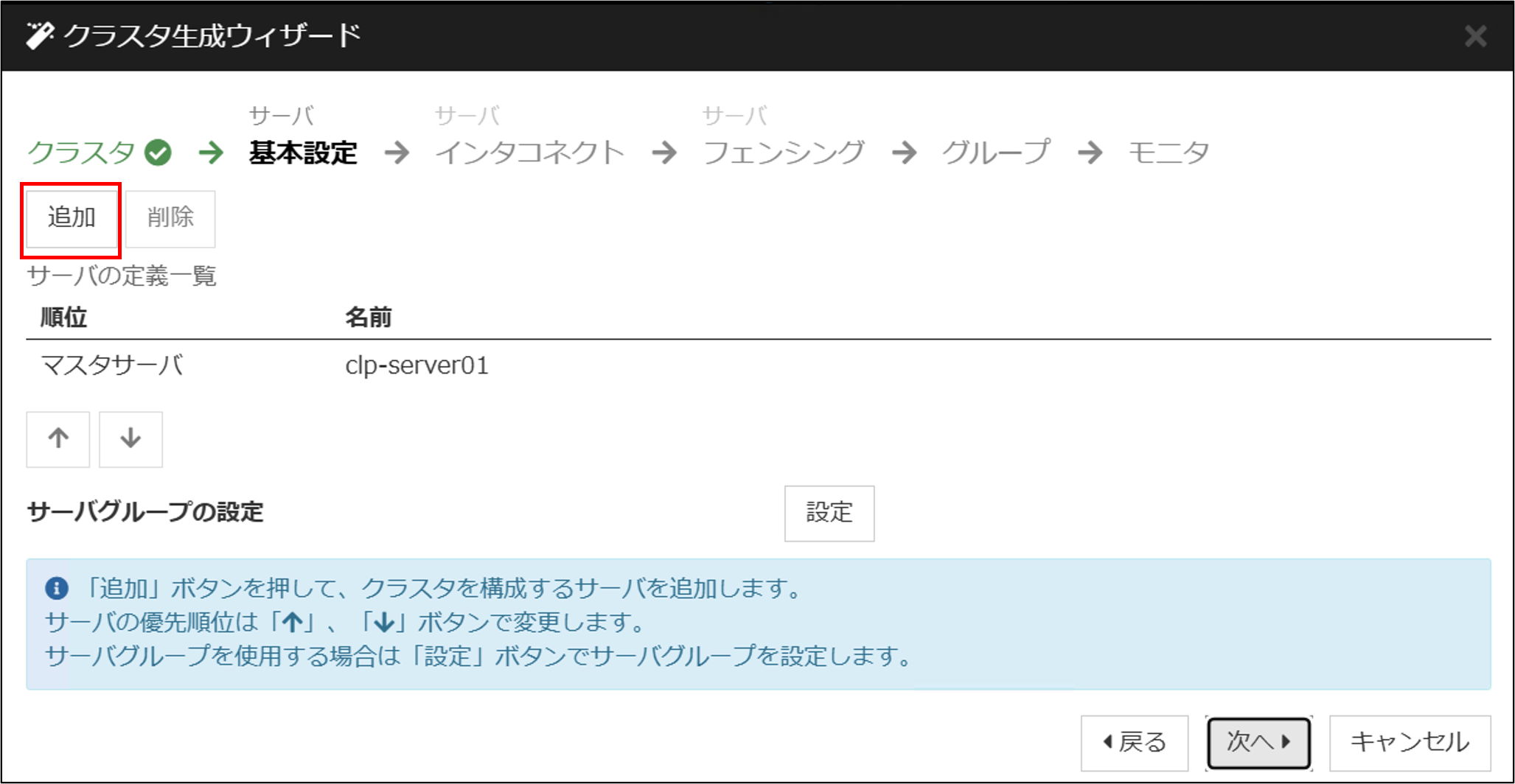

HAクラスターを構成するサーバーを追加します。[追加]をクリックします。

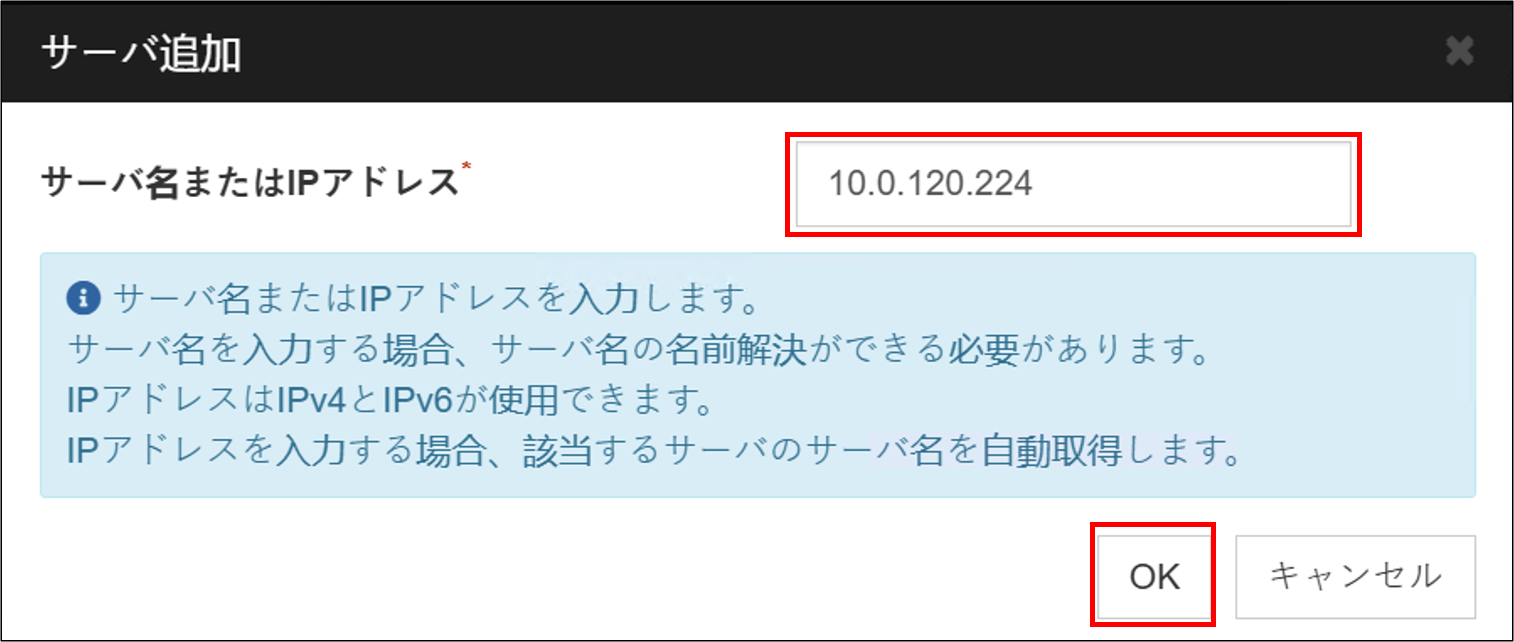

HAクラスターを構成する相手サーバー(clp-server02)のIPアドレスを追加し、[OK]を選択します。

サーバーが追加されたら[次へ]を選択します。

インタコネクトの設定をします。[追加]をクリックして通信経路を追加し、各インスタンスのIPアドレスを設定します。このインタコネクトはミラーディスクコネクト(データミラーリング通信に利用する経路)としても利用するので、[MDC]列をmdc1に割り当てます。これはミラーディスクリソースの設定時に使用します。

ネットワークパーティション解決(NP解決)リソースを設定します。[追加]を選択し、HTTP方式のNP解決を選択します。ターゲットに「aws.amazon.com」、clp-server01/clp-server02で「使用する」を選択し、[次へ]を選択します。

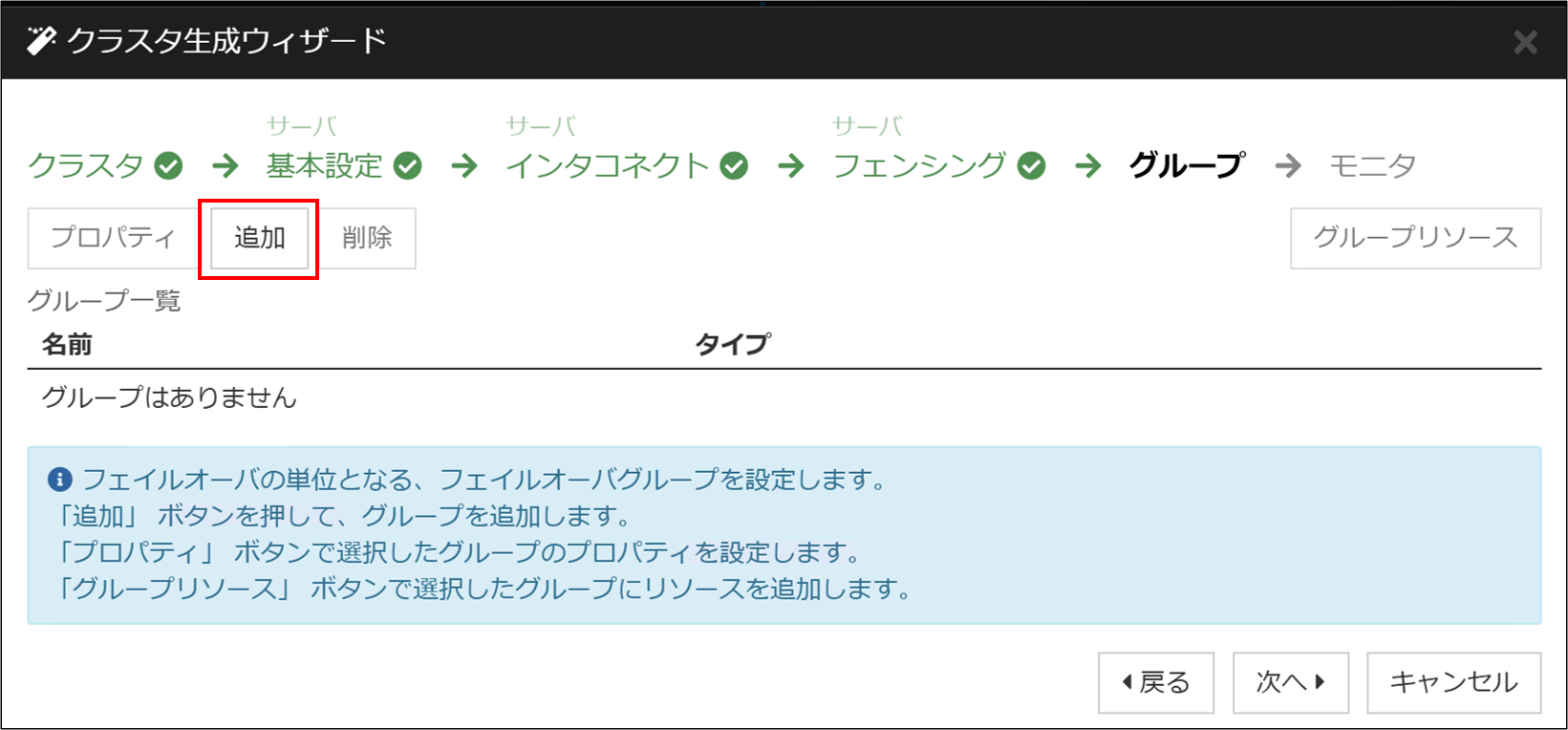

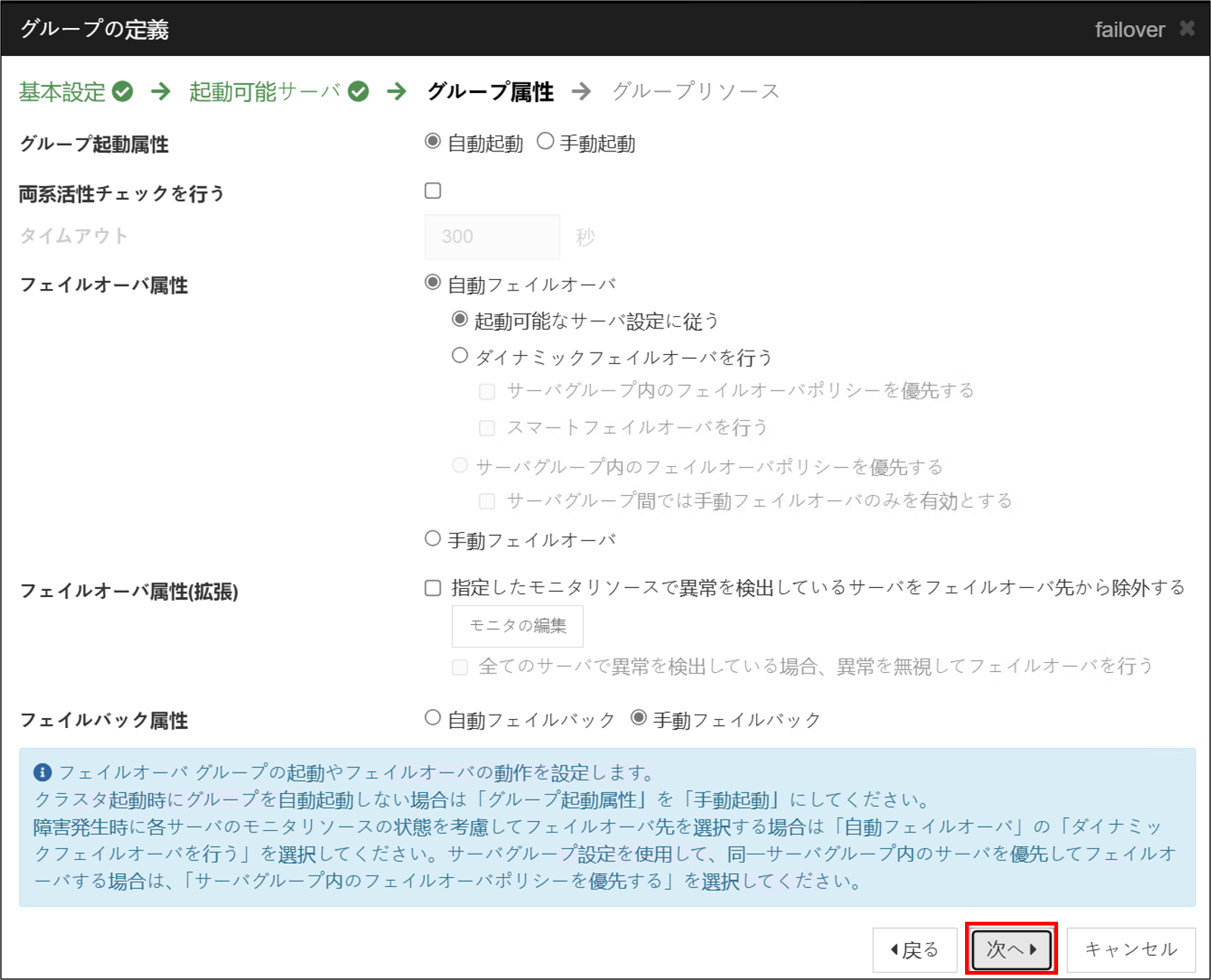

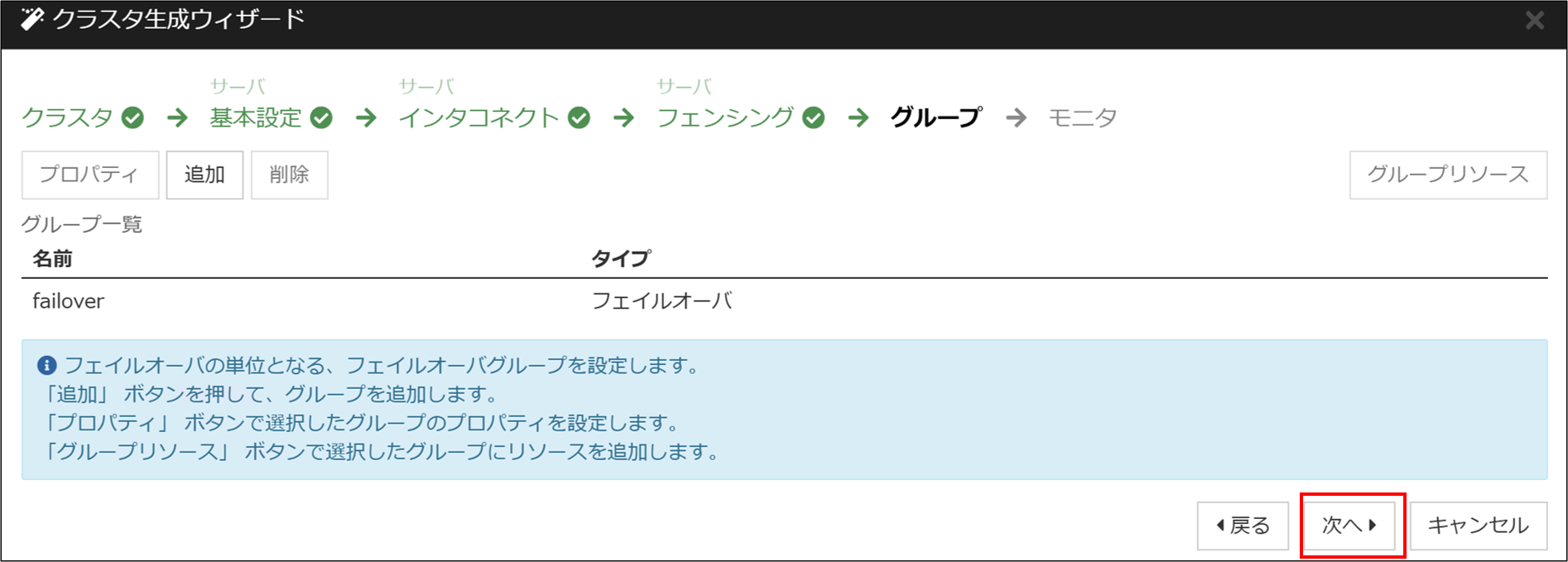

フェールオーバーグループを追加します。[追加]をクリックします。

名前は既定値のまま[次へ]を選択します。

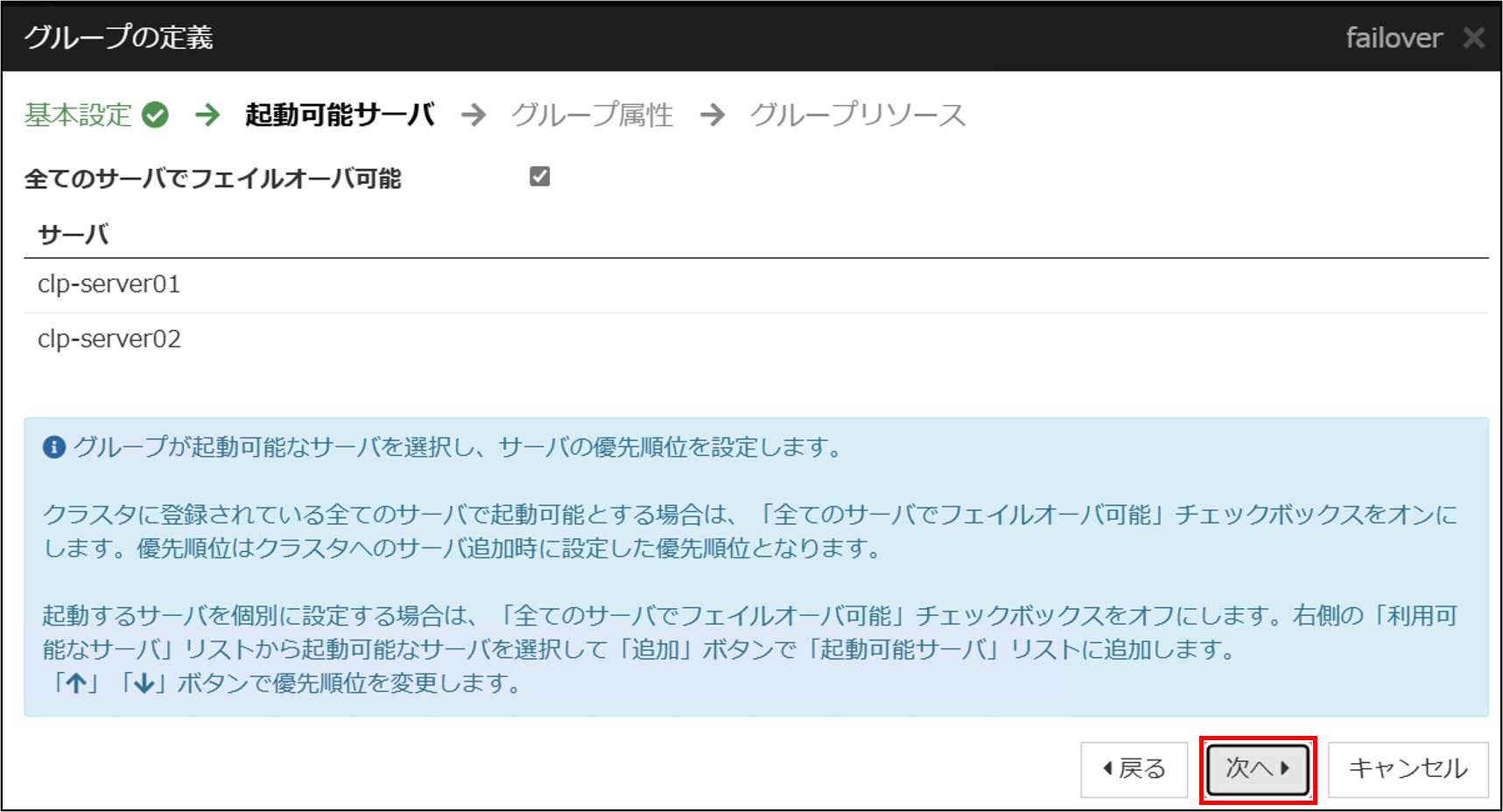

起動可能サーバを選択します。今回は既定値とします。

グループ属性を設定します。今回はすべて既定値とします。

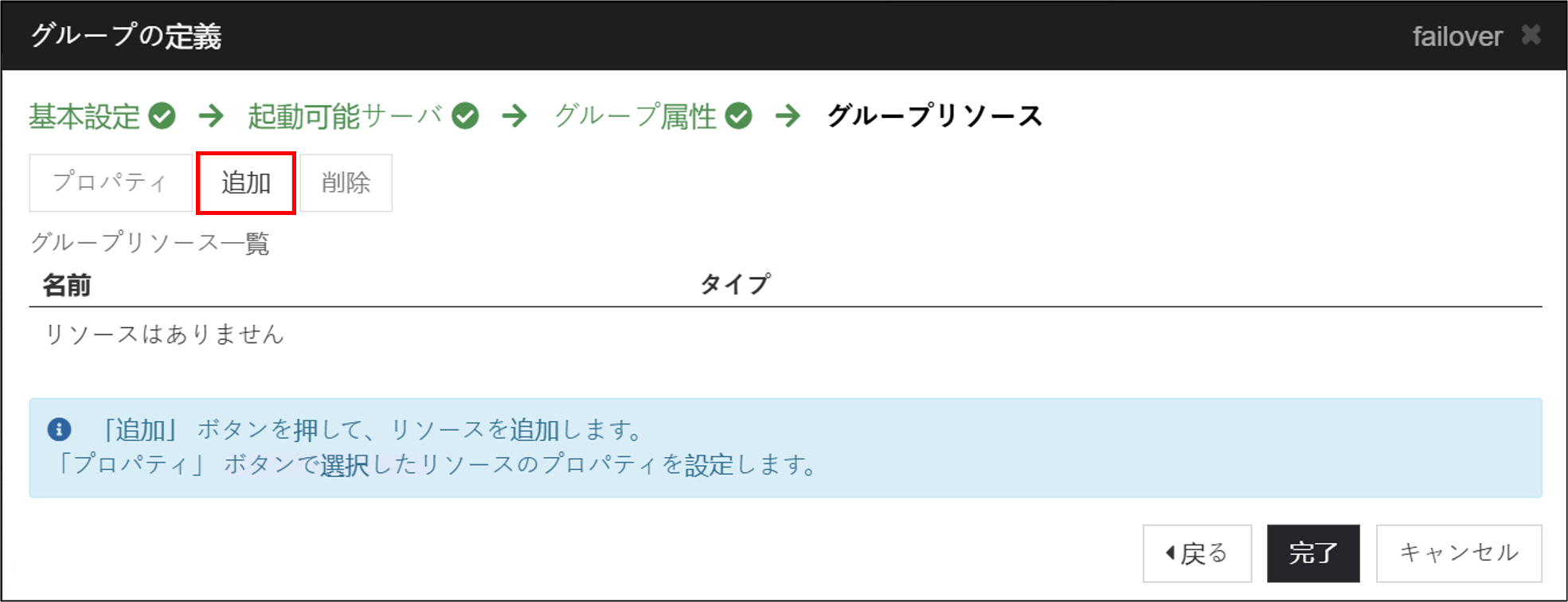

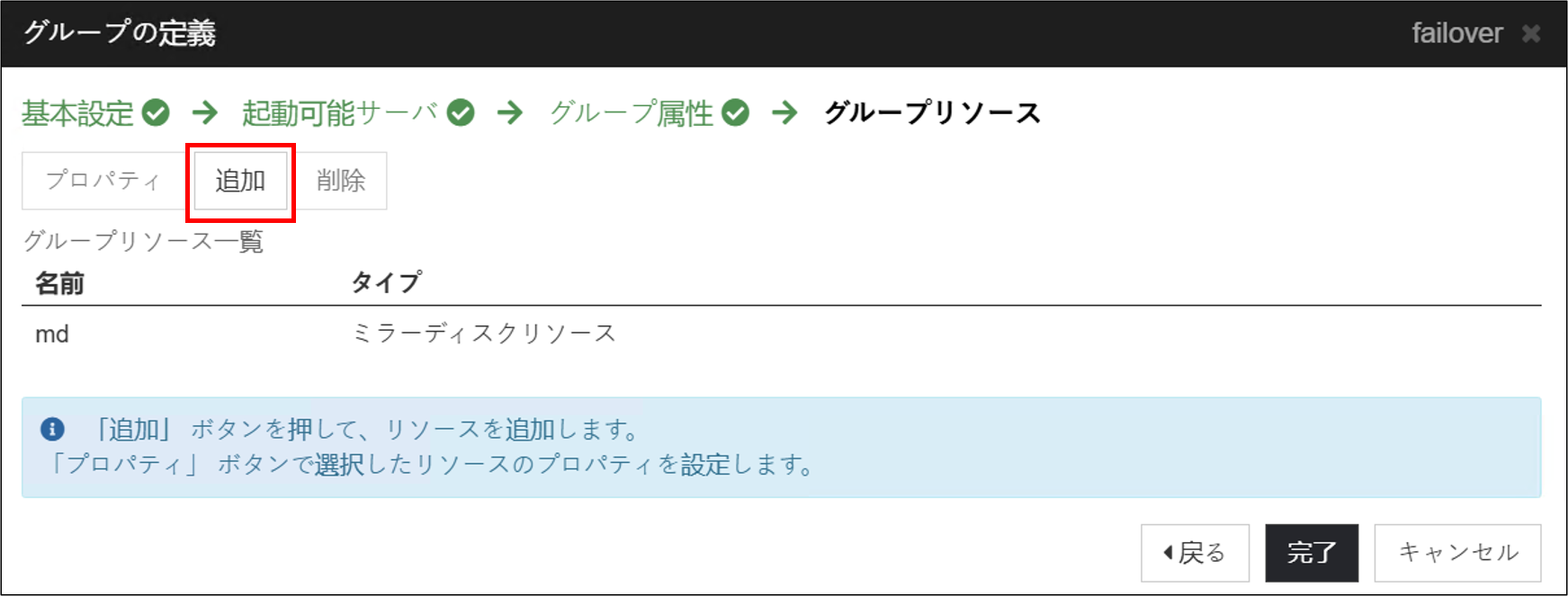

グループリソースを追加します。[追加]をクリックします。

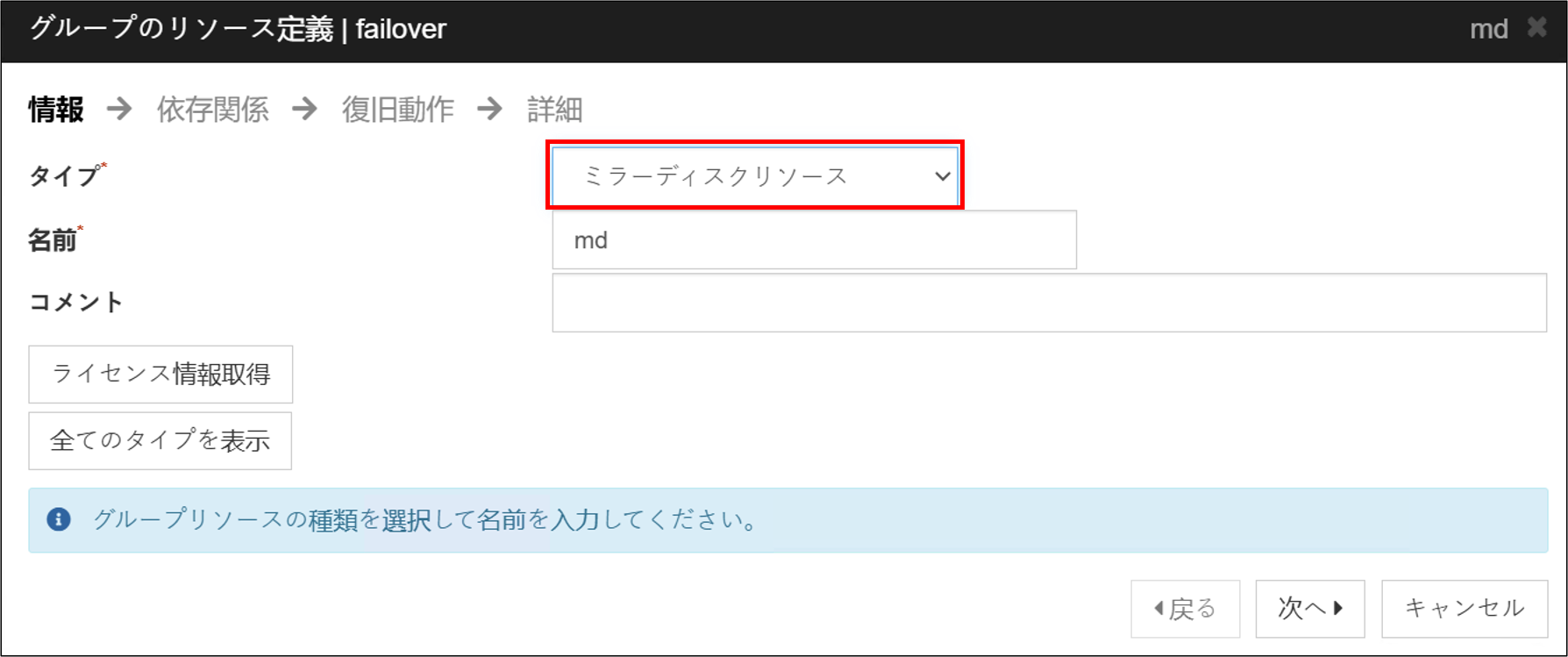

■ ミラーディスクリソース

まずはミラーディスクリソースを追加します。[タイプ]から[ミラーディスクリソース]を選択し、[次へ]をクリックします。

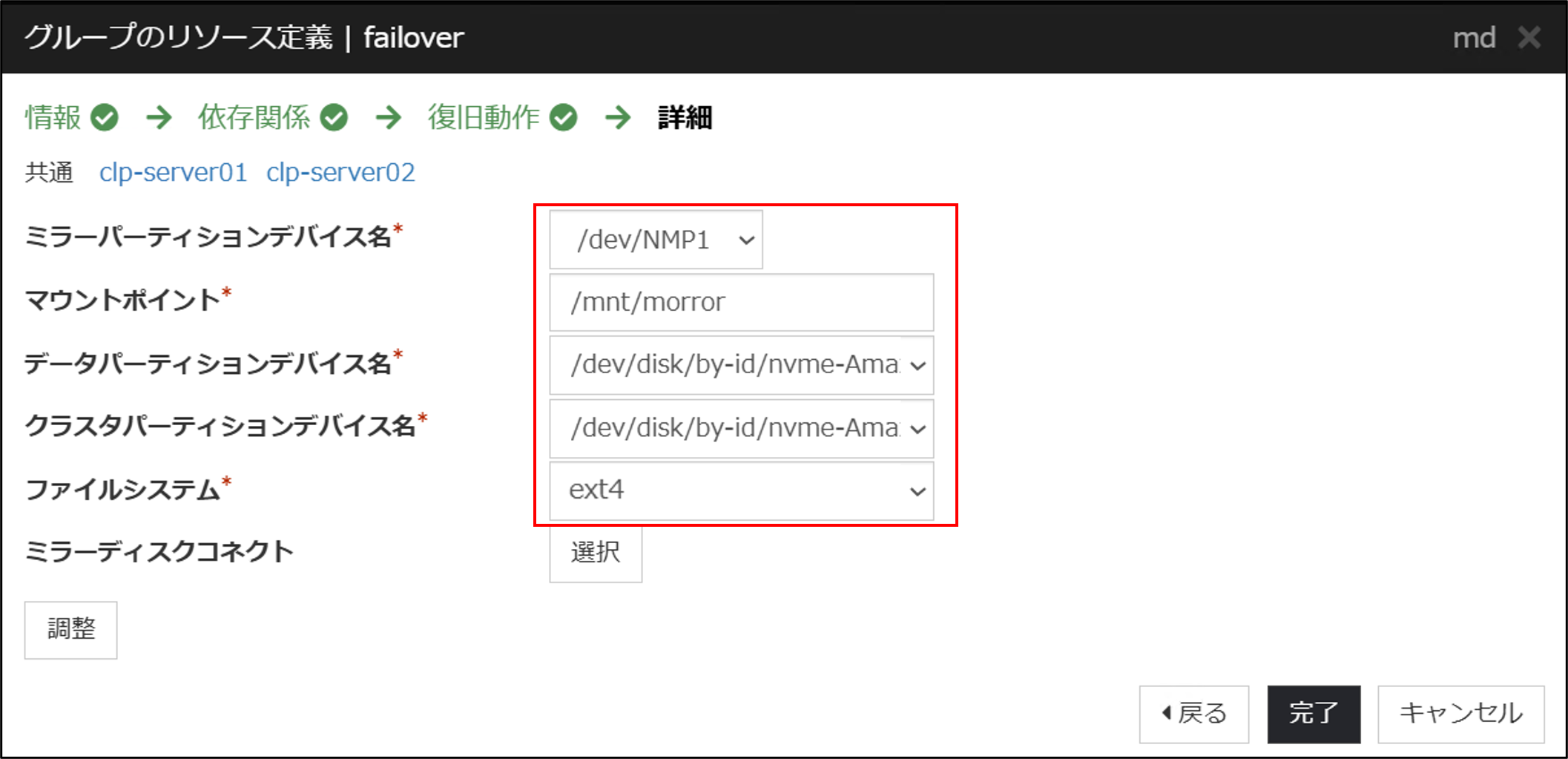

依存関係設定のページ、復旧動作設定のページは既定値のまま[次へ]をクリックし、詳細設定のページを表示します。

ミラーディスクコネクトは[選択]からミラーディスクコネクトの選択画面を開き、「mdc1」を追加します。マウントポイントには「2.2 ミラーディスクの準備」で作成したパスを指定します。また、データパーティションデバイス名、クラスタパーティションデバイス名には控えていたclp-server01のby-idのパスを設定します。

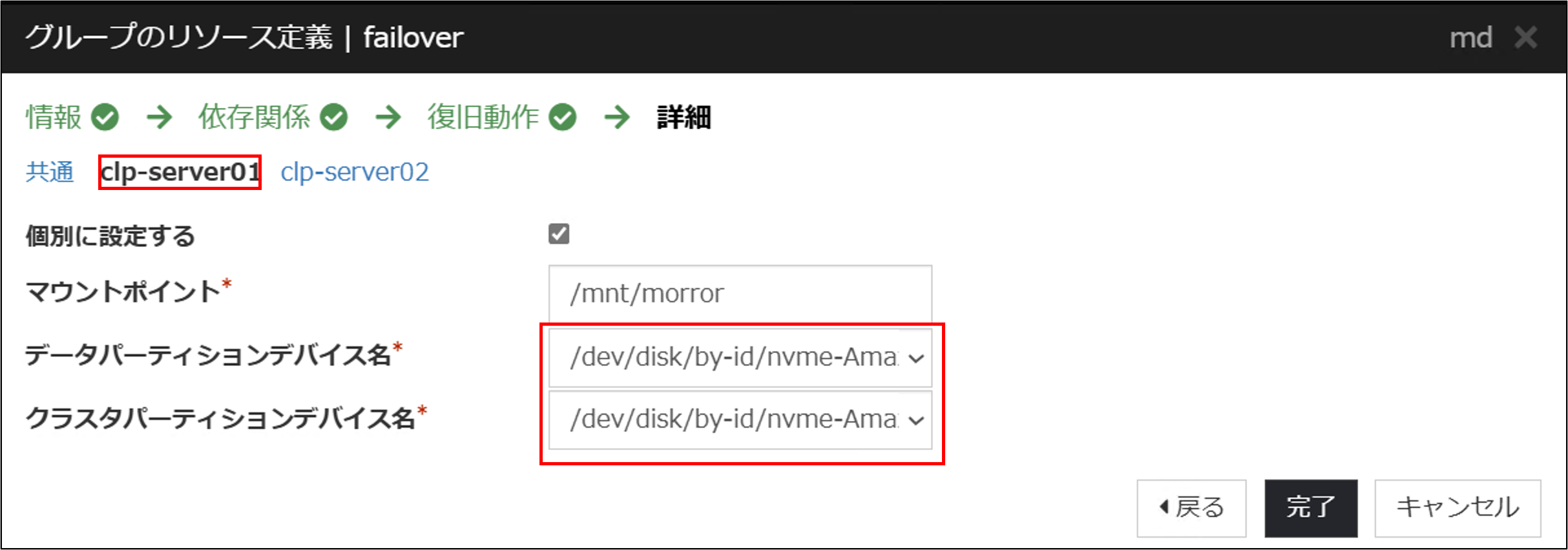

clp-server01に個別設定を行います。clp-server01タブを開いて「個別に設定する」にチェックを入れます。データパーティションデバイス名とクラスタパーティションデバイス名が正しく設定されていることを確認します。

clp-server02タブにおいても「2.2 ミラーディスクの準備」で調べたclp-server02のby-idを個別設定します。[完了]をクリックして選択を完了します。

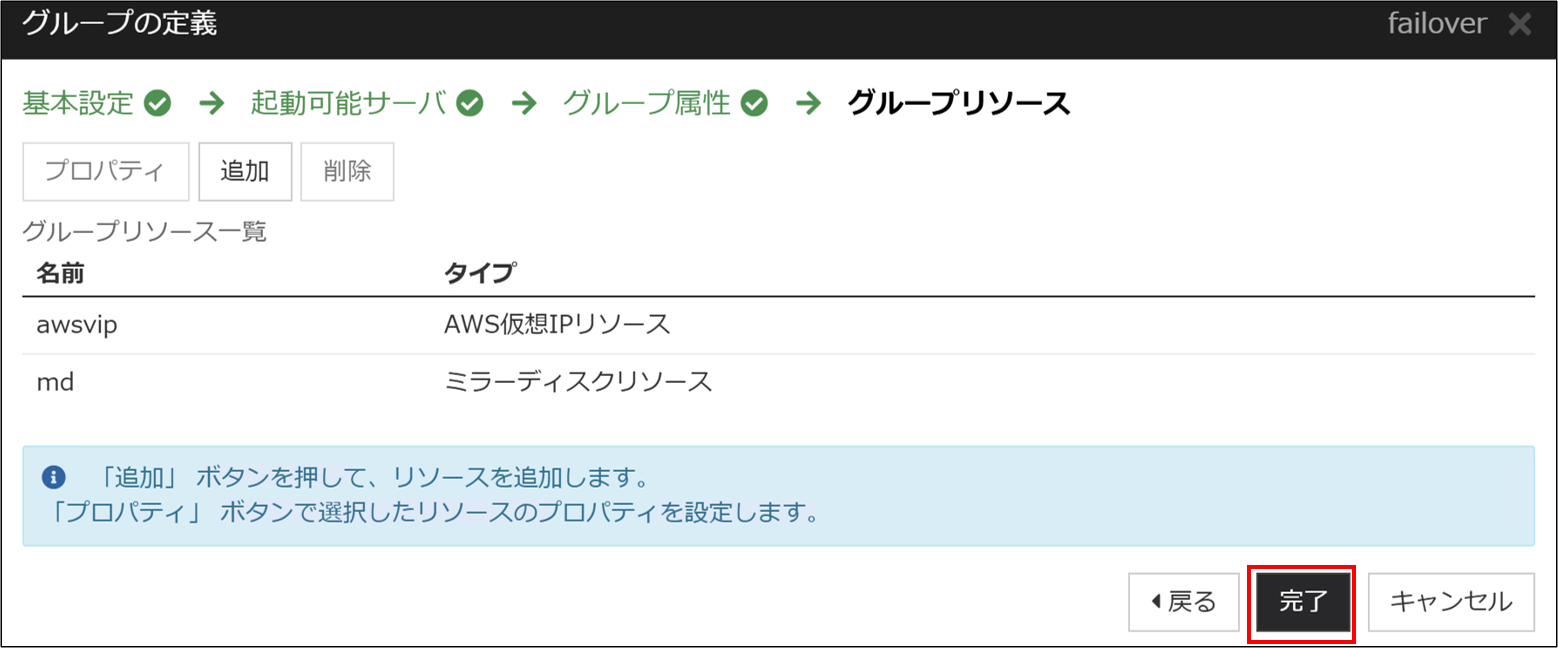

ミラーディスクリソースが追加されました。[追加]を押して新しくリソースを追加します。

■ AWS仮想IPリソース

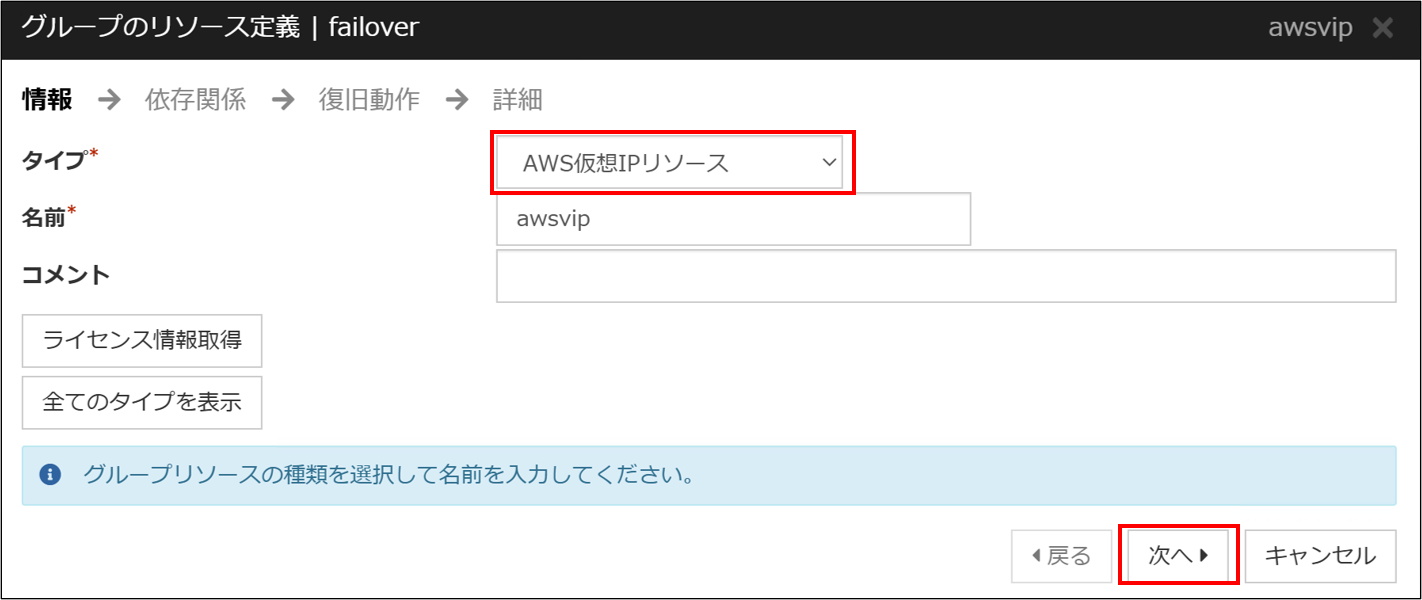

次にAWS仮想IPリソースを設定します。[タイプ]から[AWS仮想IPリソース]を選択します。

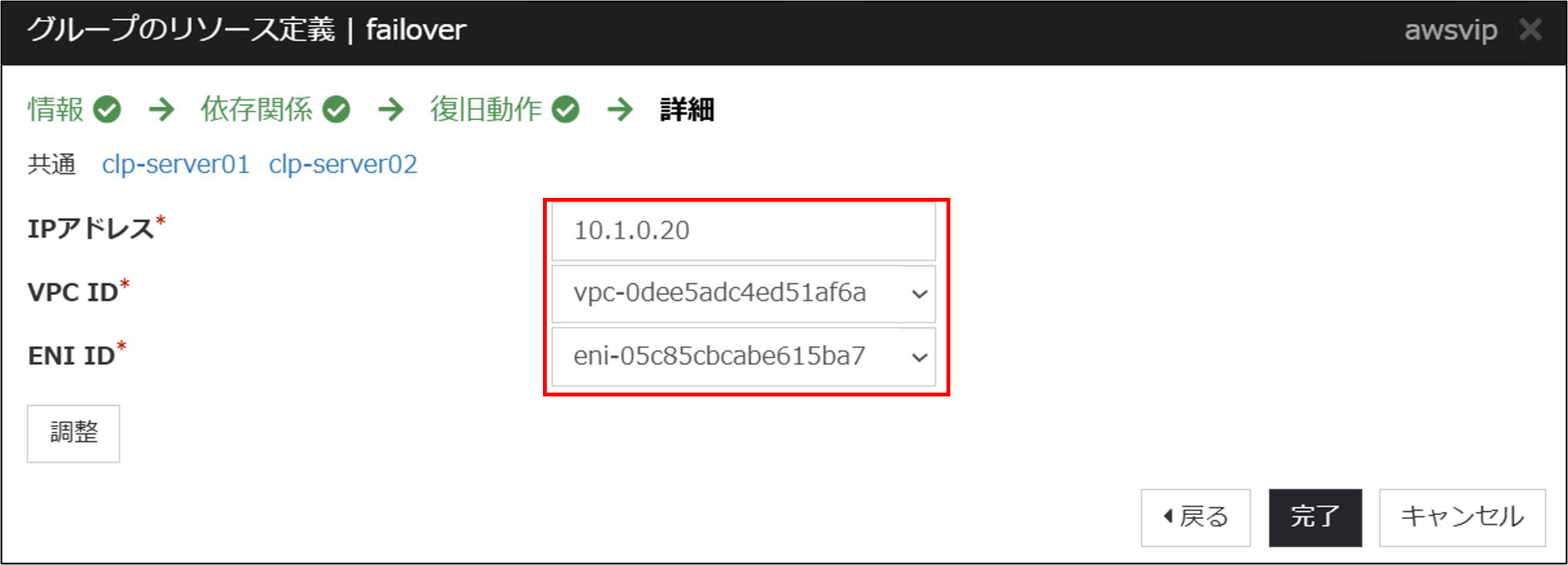

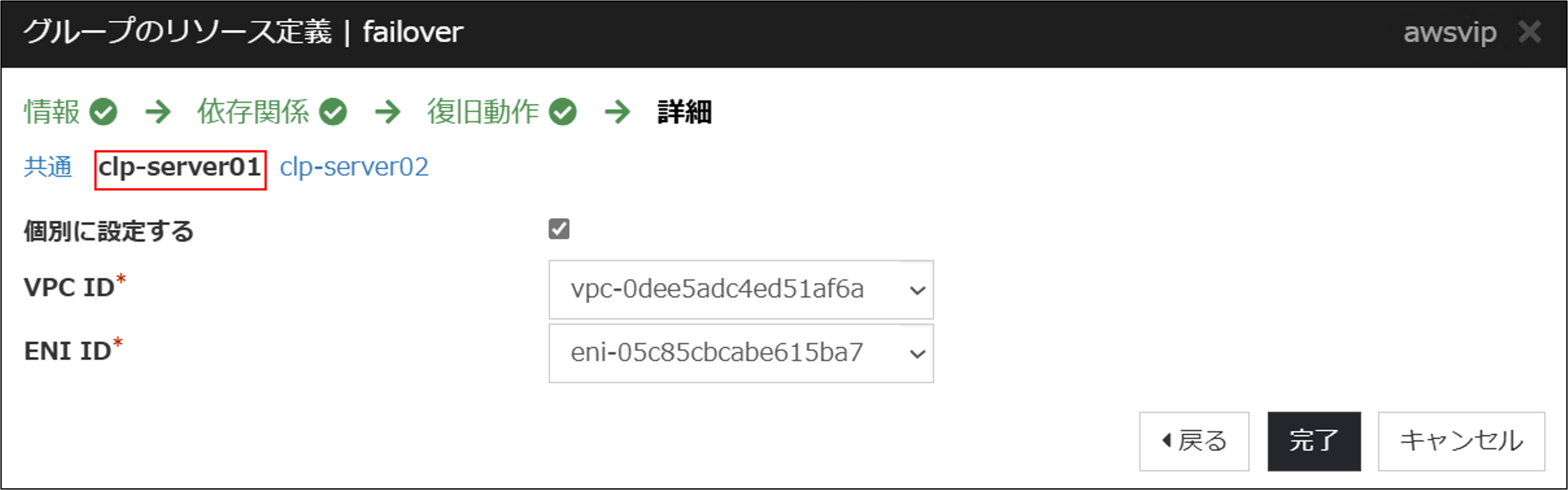

依存関係設定のページ、復旧動作設定のページは既定値のまま[次へ]をクリックし、詳細設定のページを表示します。共通タブでは利用するVIPをIPアドレス欄に入力します。VPC IDおよびENI IDはドロップダウンリストから選択できますので、EC2インスタンスが属するVPC IDとclp-server01のENI IDを設定します。

各サーバーの個別設定を行います。まずはclp-server01タブを開き、「個別に設定する」にチェックを入れます。VPC IDとclp-server01のENI IDを設定します。

同様にclp-server02タブを開き、「個別に設定する」にチェックを入れます。VPC IDとclp-server02のENI IDを設定し、[完了]をクリックします。

グループリソースの追加が完了したら[完了]を選択します。

フェールオーバーグループの設定が完了したら[次へ]を選択します。

追加したグループリソースに応じてモニタリソースが追加されています。[完了]を押して設定を完了します。

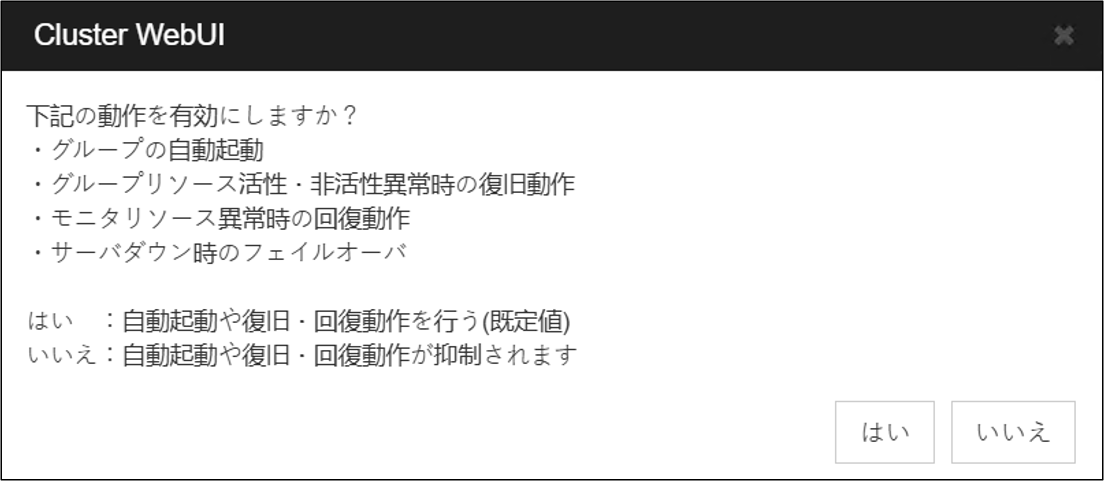

自動起動や復旧・回復動作の設定ポップアップが表示されます。[はい]をクリックします。

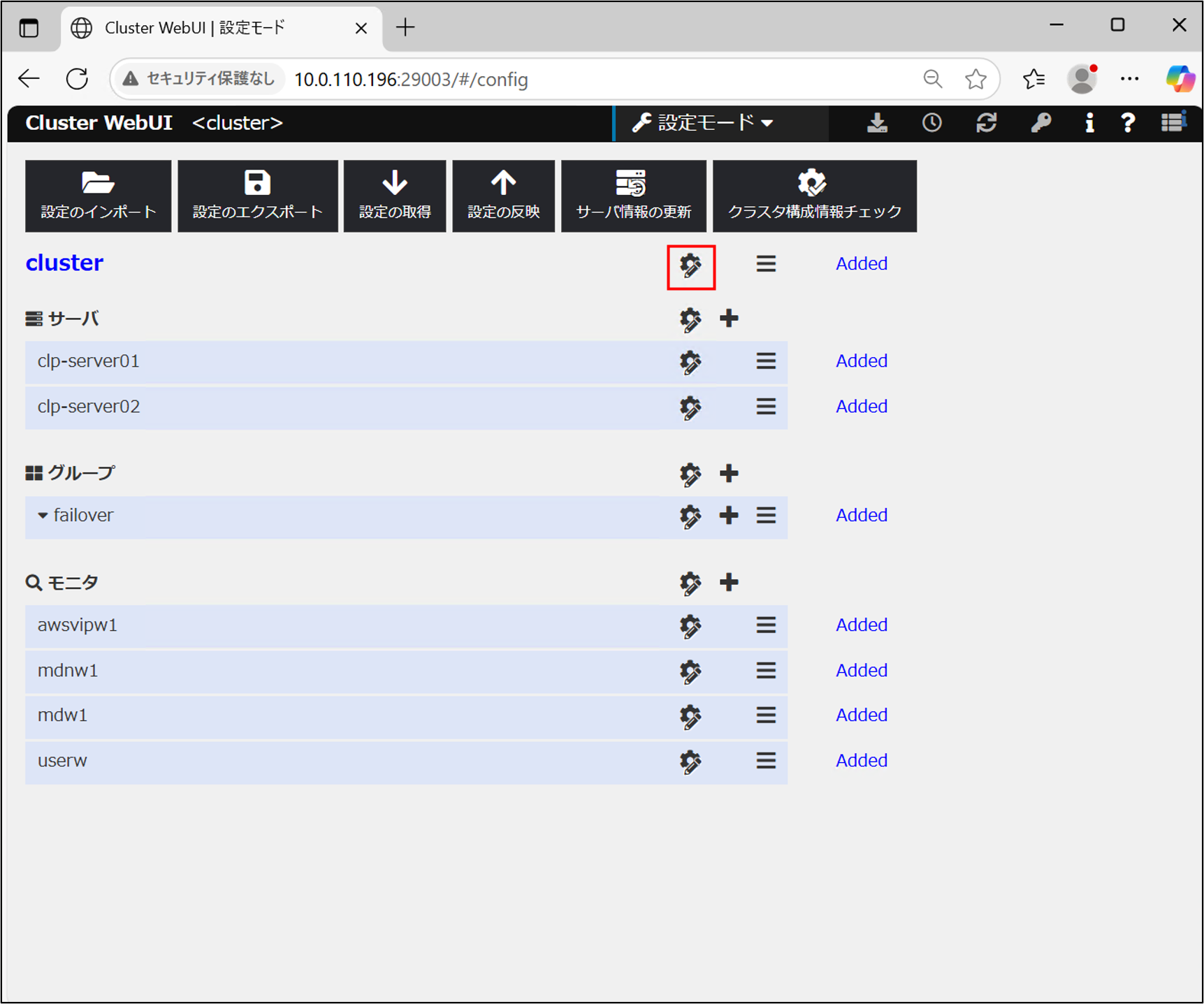

構成したクラスターリソースの一覧が表示されます。クラスターの設定を開きます。

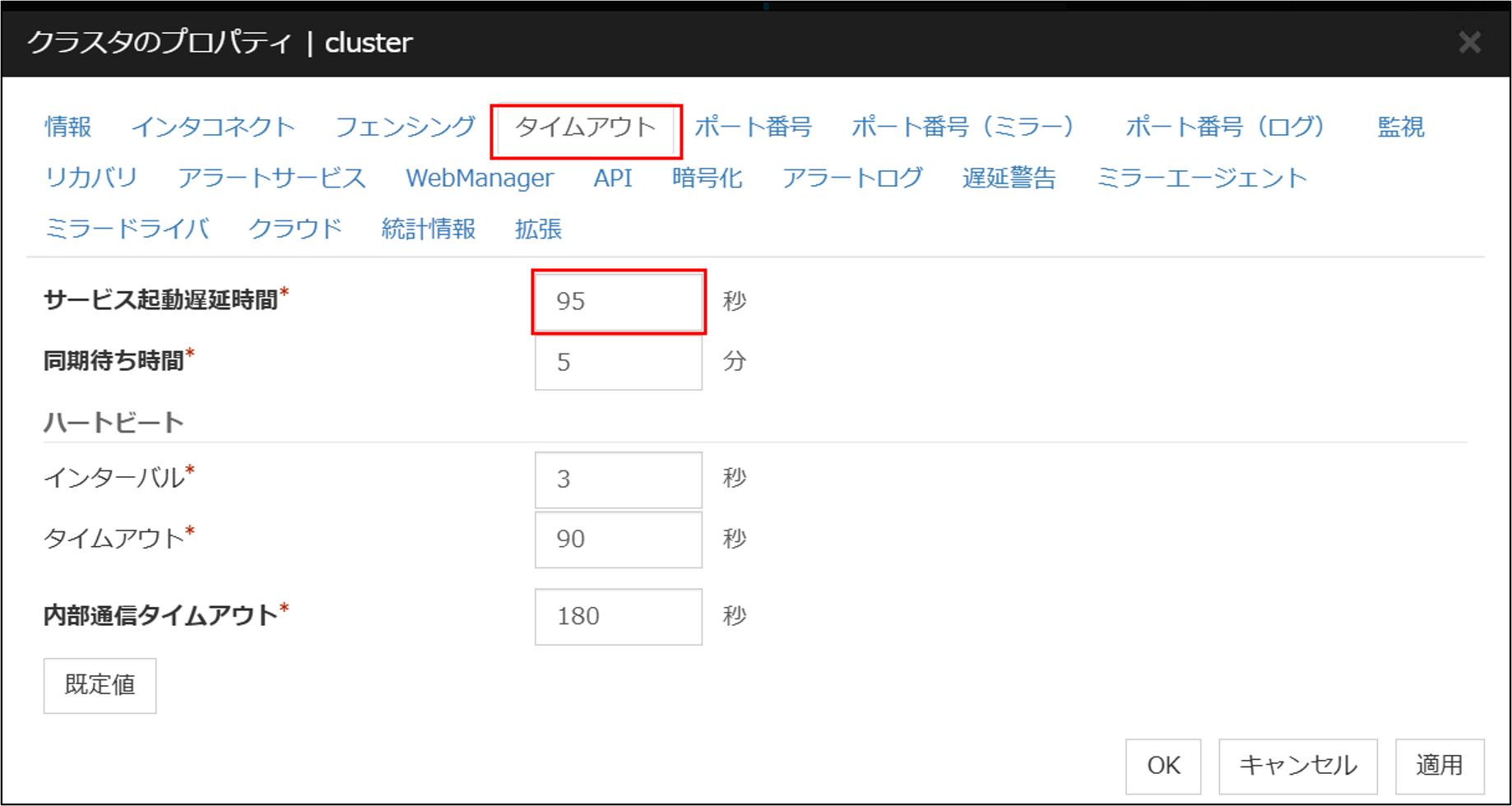

タイムアウトタブからサービス起動時間の設定を行います。サービス起動遅延時間をハートビートタイムアウト時間 + ハートビートインターバル時間より長くなるように設定します。今回はハートビートタイムアウトが90秒、ハートビートインターバルが3秒のため、95秒を設定します。

利用するリソースに応じて設定する時間は異なります。サービス起動遅延時間の設定に関する詳しい解説は以下の記事をご参照ください。

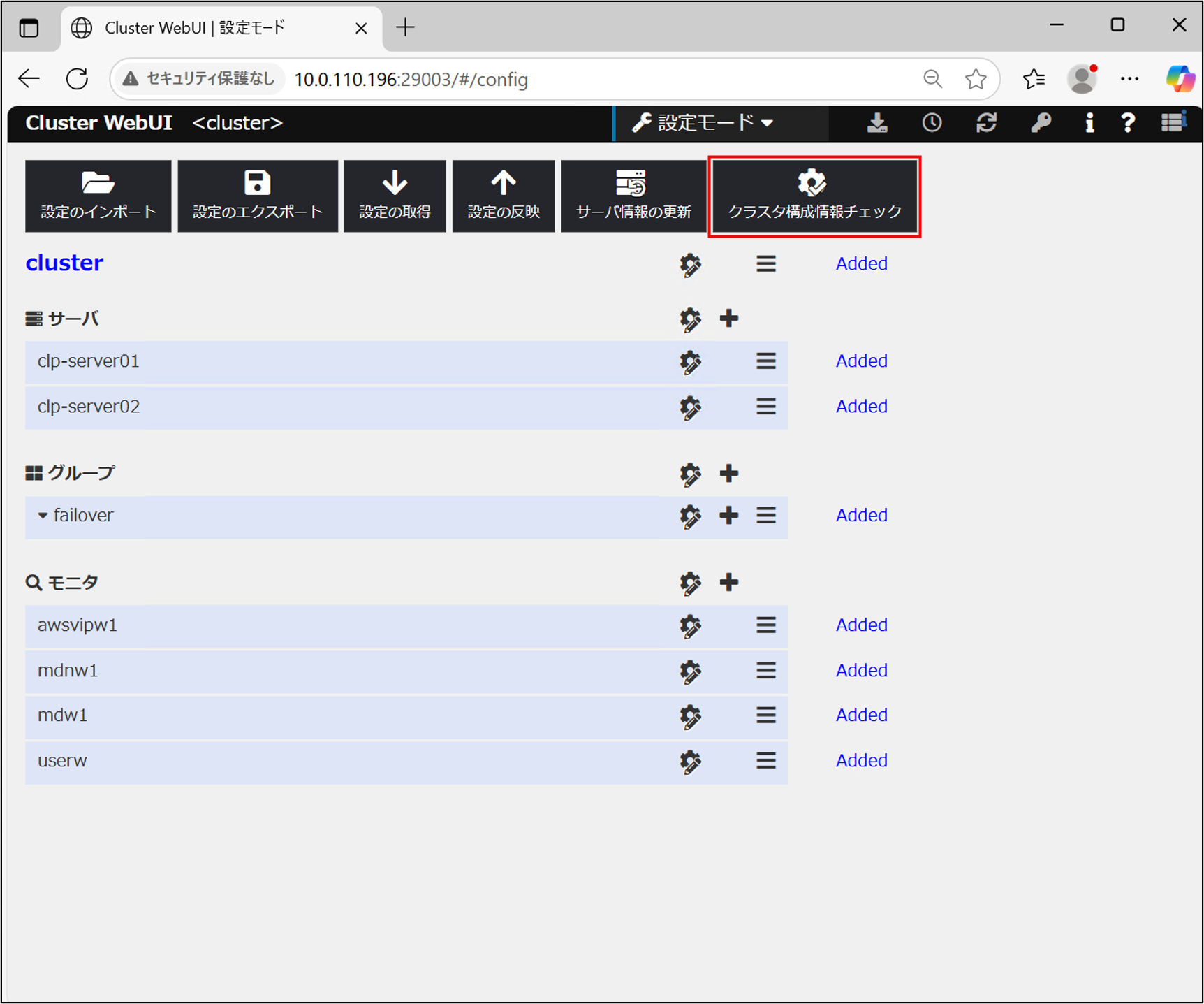

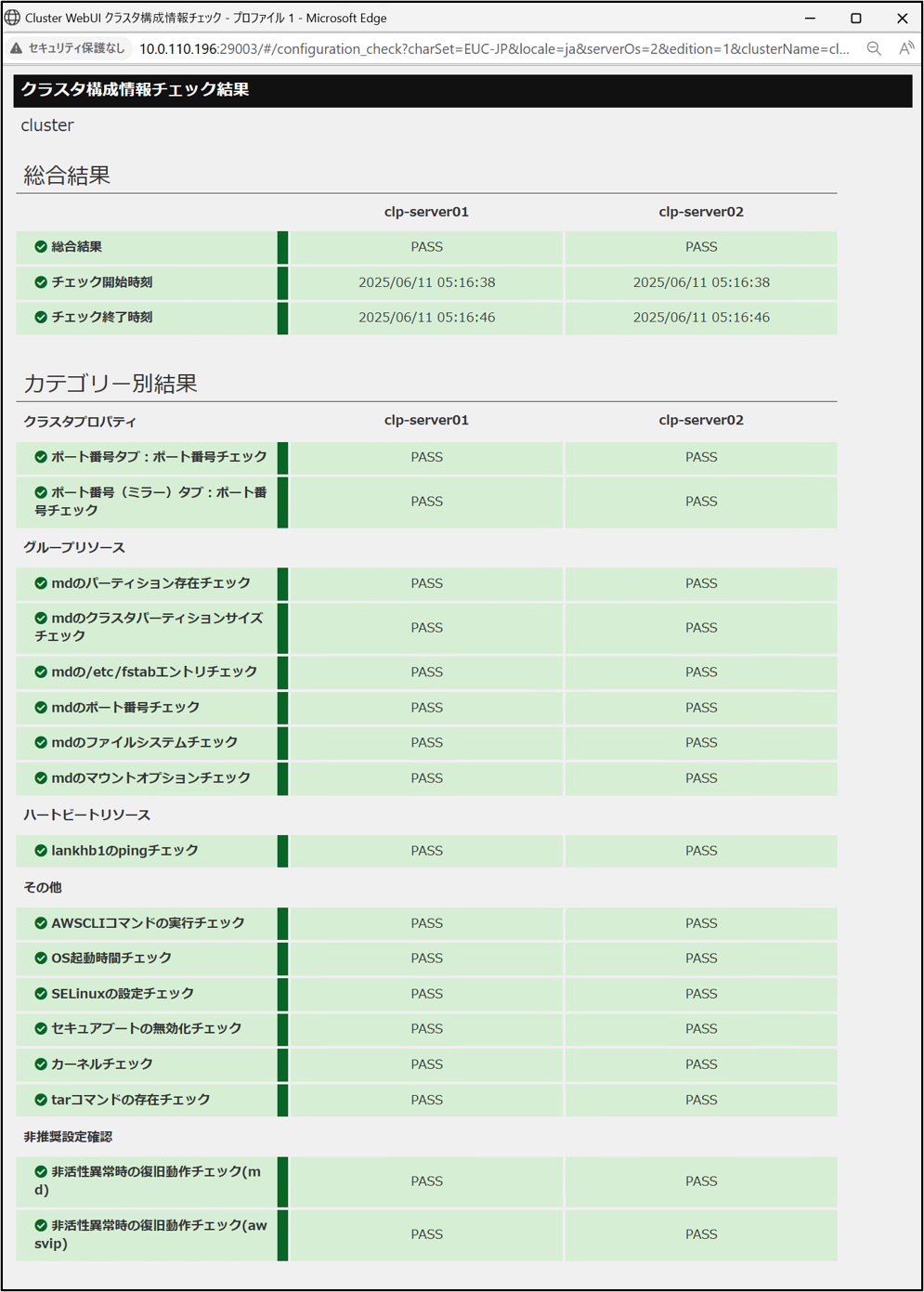

クラスター構成情報のチェックを行います。

構成情報の設定が正しくできているかを確認することができます。エラーが出た場合はその箇所の設定を確認してください。

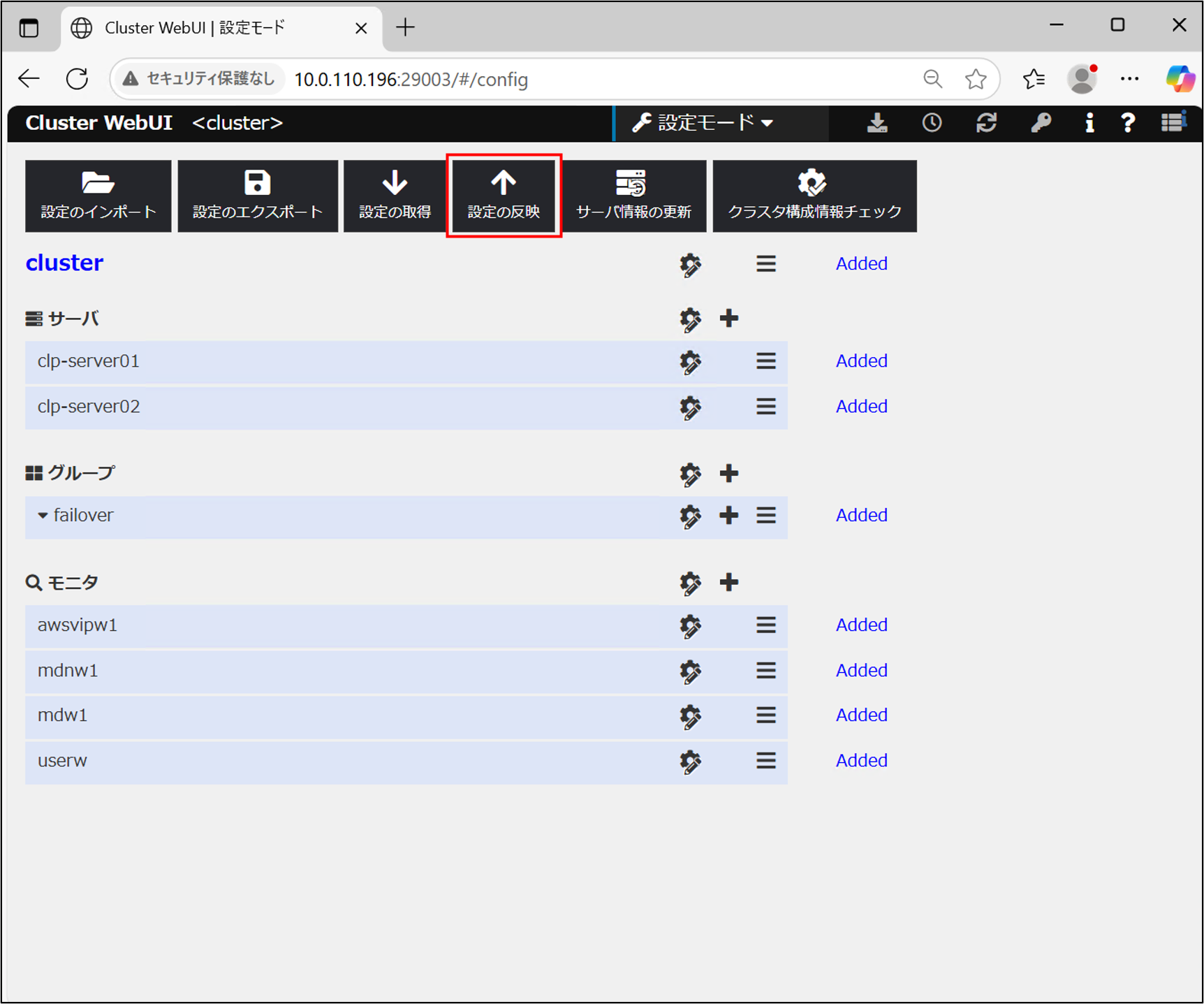

構成情報に問題がなければクラスタ構成情報チェック結果のウィンドウを閉じ、[設定の反映]を選択します。

サービス再起動に関するポップアップが出たら[はい]を選択します。設定が各サーバーに反映されます。

「3.2.1. ファイアウォールの設定」でファイアウォールを設定していた場合、構成情報の反映完了後、ミラー通信用のポートを開放するためにclpfwctrlコマンドを再び実行します。clp-server01、clp-server02にログインし、以下のコマンドを実行します。

$ sudo clpfwctrl.sh --add

Command succeeded.

ミラーディスクリソースを利用する場合、構成反映後に全サーバーの再起動が必要です。clp-server01、clp-server02の両方でclpfwctrl.shコマンドが成功したことを確認したら、各サーバーをそれぞれ再起動します。

$ sudo reboot

5. HAクラスターの動作確認

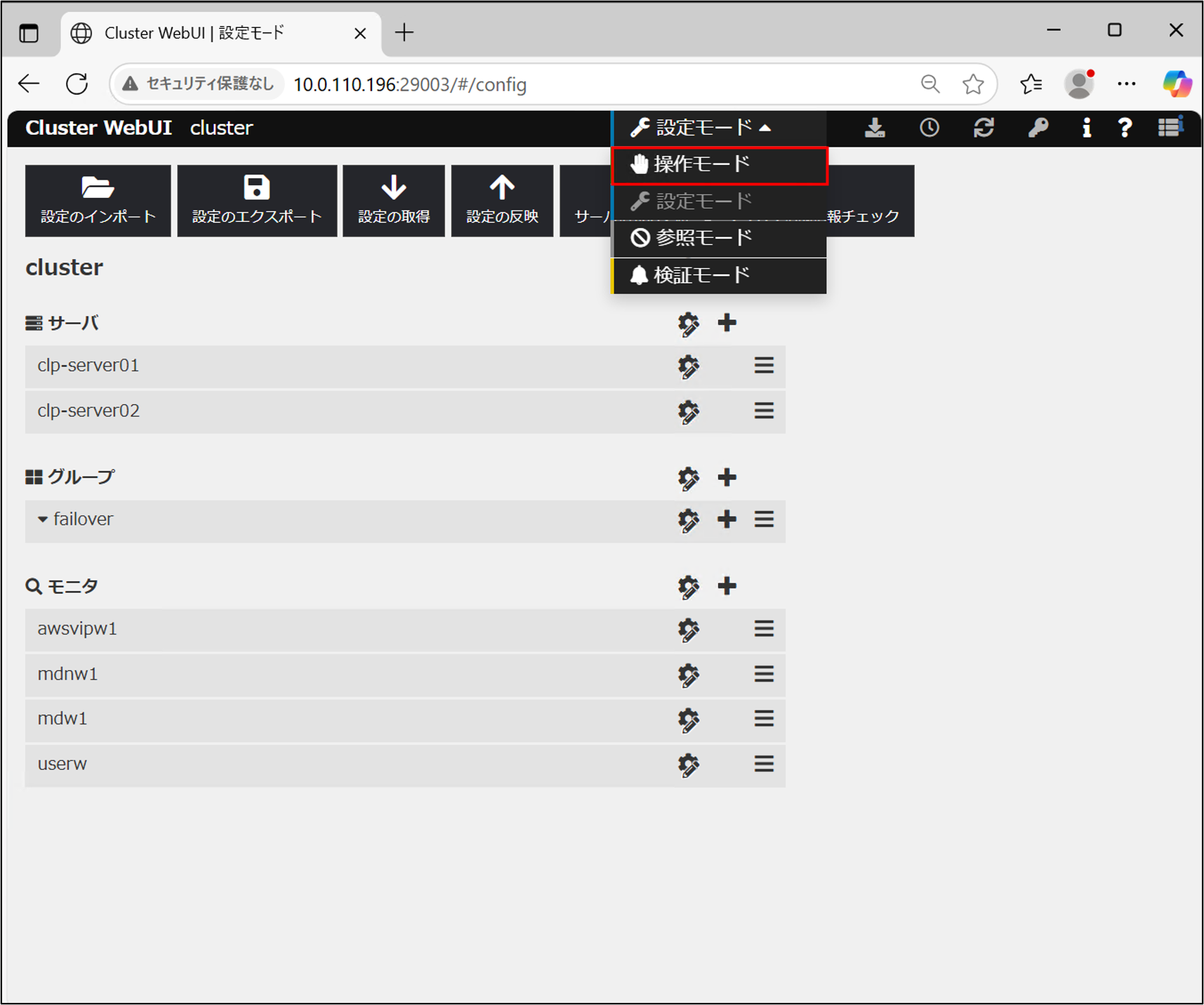

サーバーが起動したらCluster WebUIに再接続し、モードを操作モードに切り替えます。

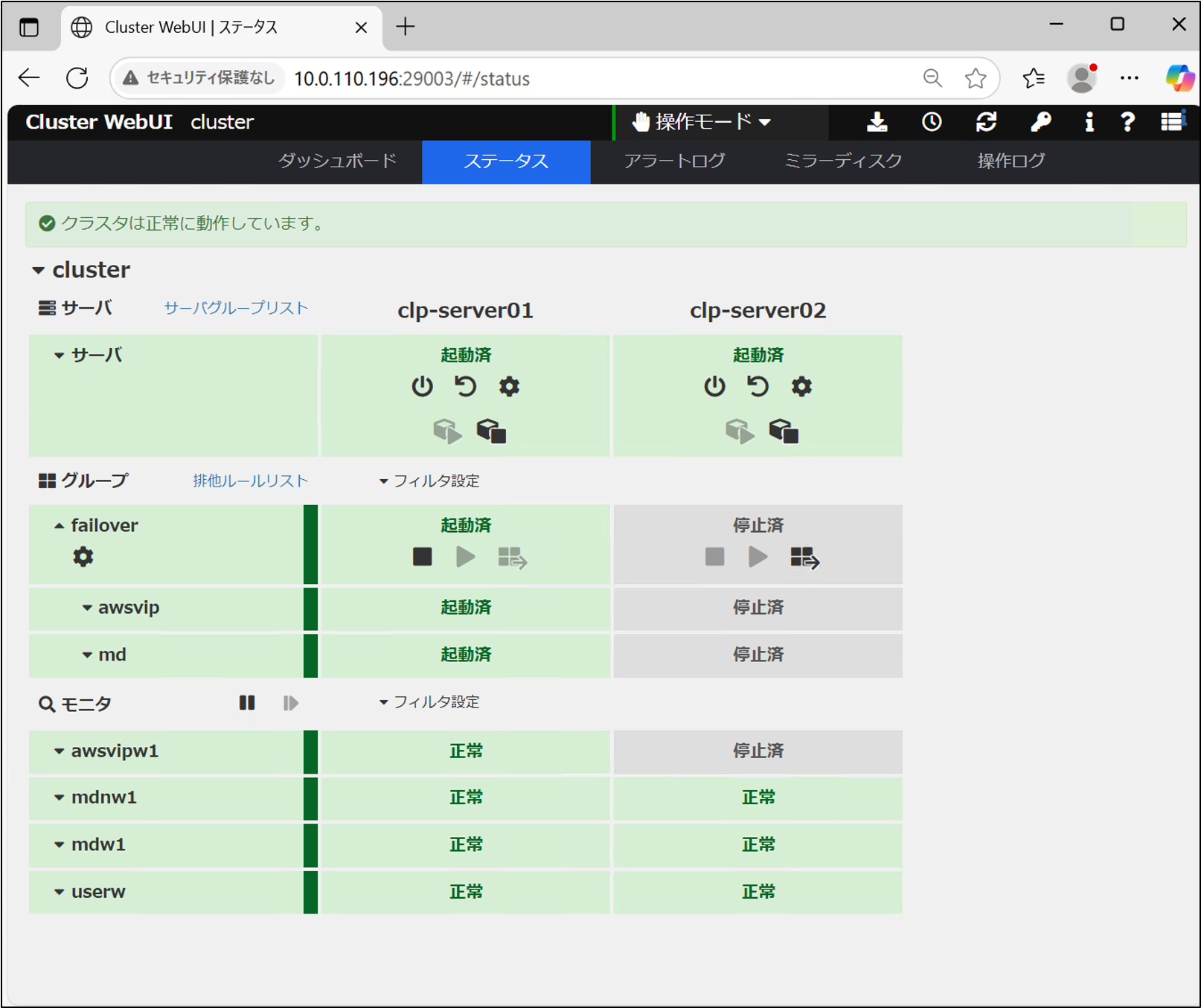

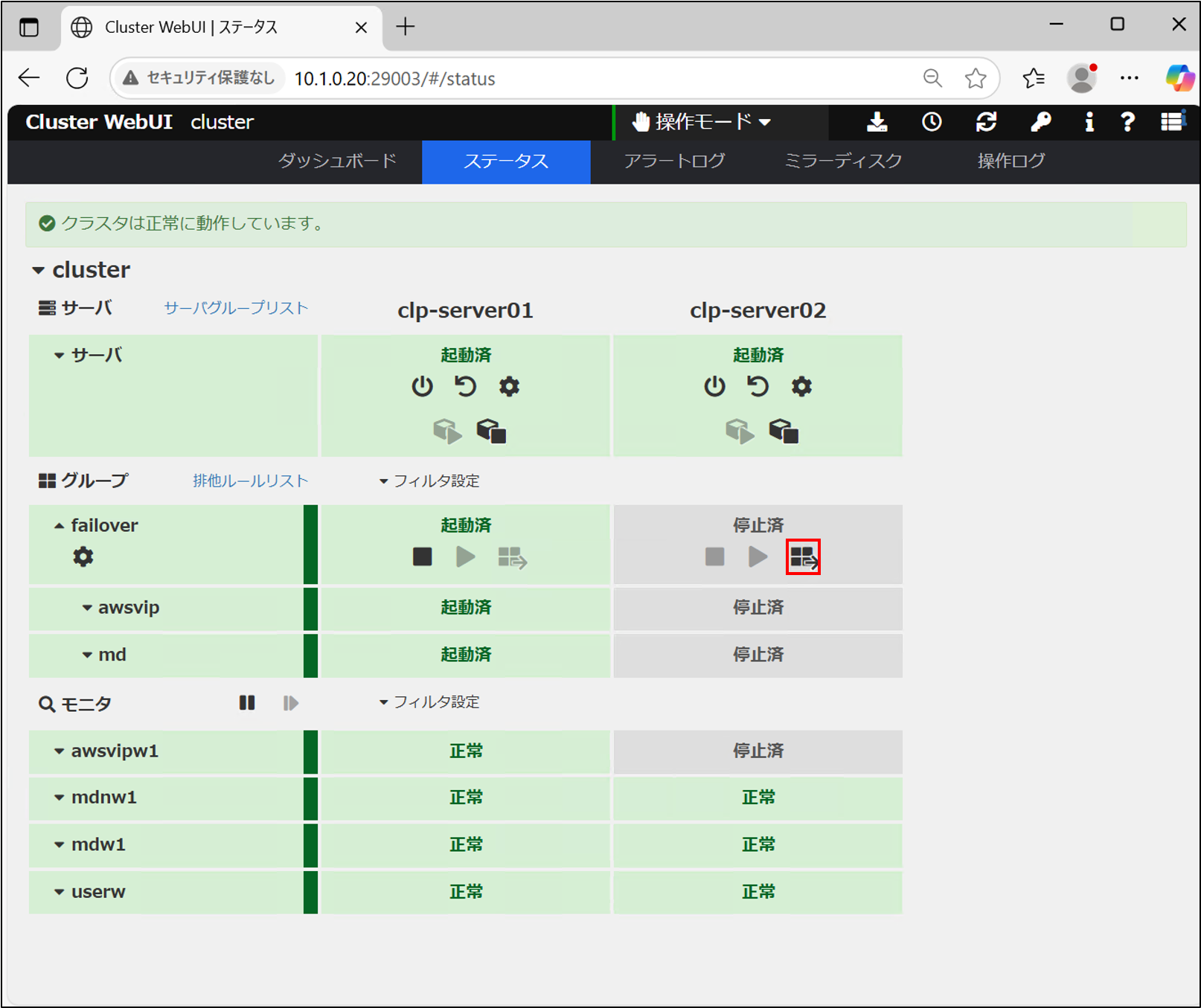

ダッシュボードが開くので、ステータスタブに切り替えます。OSが起動後サービス起動遅延時間が経過すると、クラスターサービスが開始します。クラスターの起動に成功した場合、以下のような画面になります。

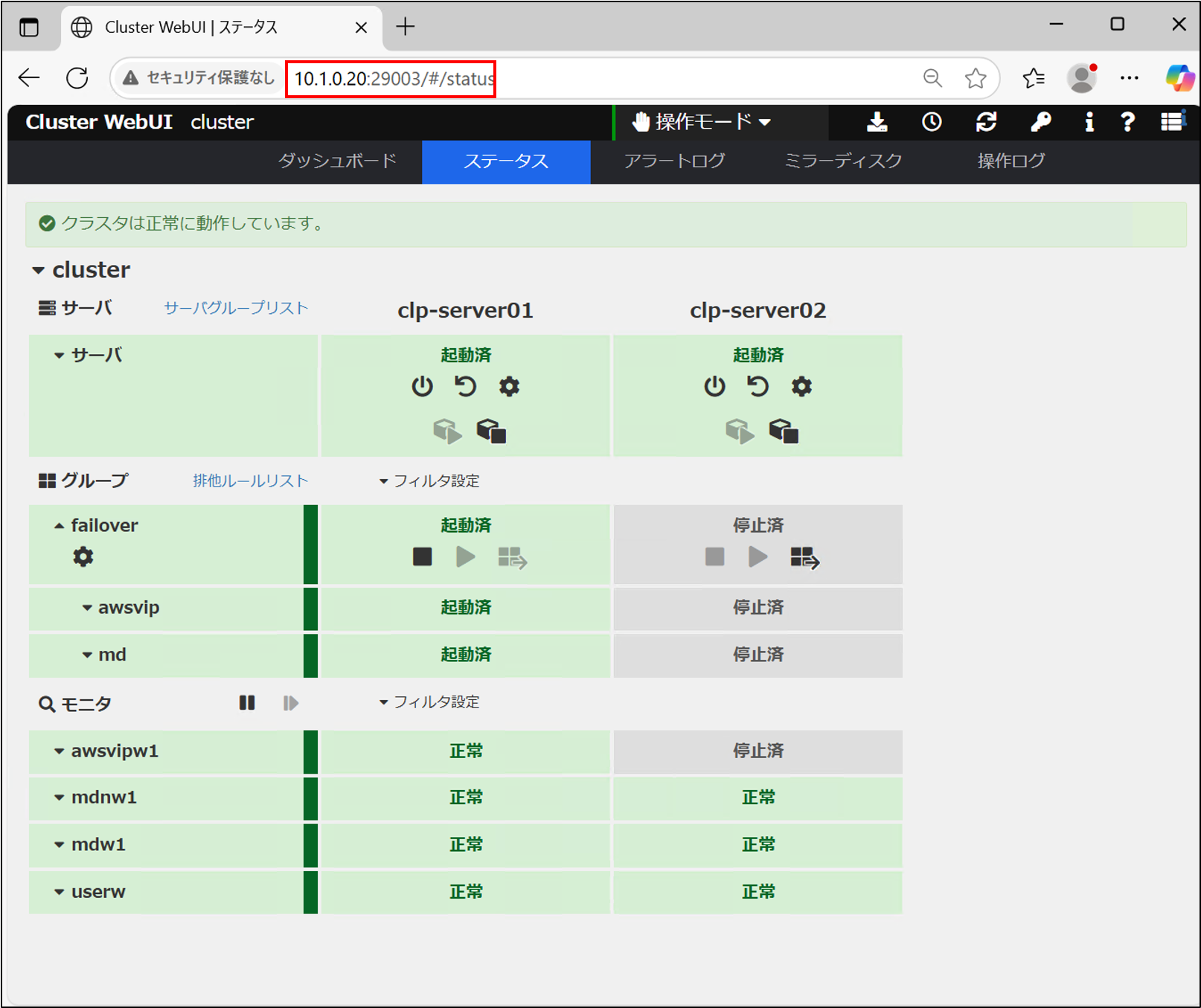

VIPアドレスでアクセスできることを確認するため、Cluster WebUIにVIPで接続します。

http://10.1.0.20:29003/

HAクラスターにVIP経由でアクセスできることが確認できました。

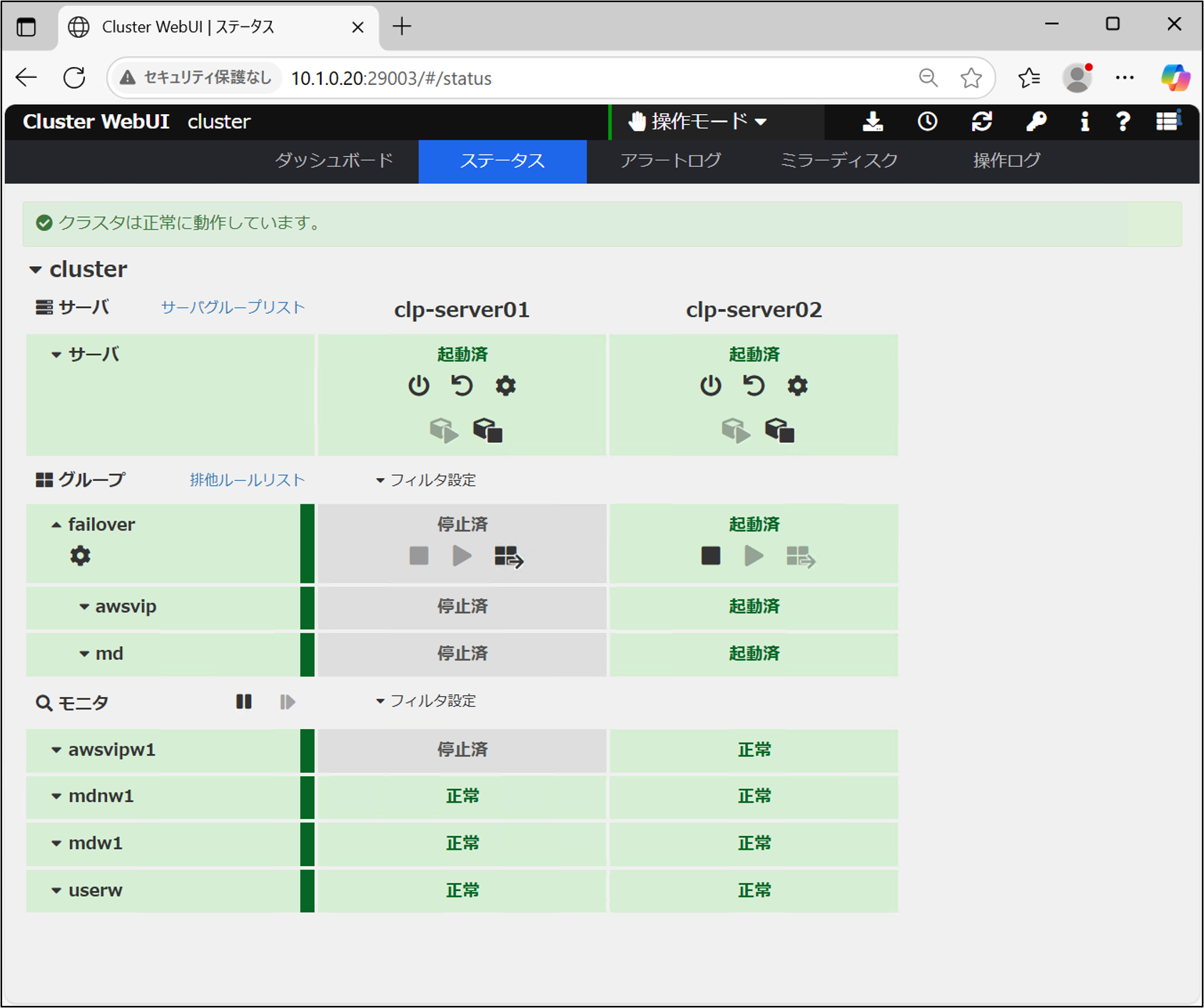

グループをフェールオーバーし、待機系でもフェールオーバーグループが起動することを確認します。clp-server02の[グループ移動]ボタンを選択し、フェールオーバーさせます。

clp-server02でフェールオーバーグループが正常に起動したことを確認します。

これにより、両系でフェールオーバーグループが起動できることが確認できました。

さいごに

今回は「0から始める」と題して、AWS上でLinuxインスタンスを用いてHAクラスターを構築するためのOS設定、CLUSTERPROのインストールからCluster WebUI上でのHAクラスター構築手順についてキャプチャ画像も交えながら具体的な手順について解説しました。前記事のAWS設定編とあわせて、HAクラスター構築までの全体像が把握できる解説記事として参考になれば幸いです。

また本記事の構成を応用することで、さまざまなアプリケーションと組み合わせたHAクラスターシステムをAWS上で構築することが可能です。クラブロではこれまでに多様なHAクラスター構築の例をご紹介していますので、ぜひそれらもあわせてご参照ください。

利用製品

本記事の構成を構築する際に必要となる製品は以下です。

■ OS共通

– CLUSTERPRO X Media 5.2

– CLUSTERPRO X Startup Kit 5.2

■ Linux

– CLUSTERPRO X 5.2 for Linux VM (1ノードライセンス)

– CLUSTERPRO X Replicator 5.2 for Linux (1ノードライセンス)

参考

CLUSTERPRO導入支援サービス(クラウドHAコンサル)ではオンプレミスやクラウド向けのクラスター構築支援サービスを行っております。クラスターの構築支援に関するご要望がありましたら、 関連サービスの導入支援サービスの窓口までお問い合わせください。

関連サービスの導入支援サービスの窓口までお問い合わせください。

お問い合わせ

お問い合わせ窓口までお問い合わせください。

お問い合わせ窓口までお問い合わせください。

拡大表示

拡大表示